Von Frank Bosse

Diese Frage stellen sich die Klimatologen und von ihrer Beantwortung hängen politische Fragen in vielerlei Hinsicht ab. Man bedient sich dabei zweier Größen: Die „Transient Climate Response“ (TCR) und die „Equilibrium Climate Sensivity“ (ECS). Die letztere beschreibt die sich ergebende Temperatursteigerung, die nach einer Verdopplung des Treibhausgasgehalts der Atmosphäre eintritt, wenn ein neuer Gleichgewichtszustand erreicht ist. Das kann Jahrhunderte dauern. Die Energie die in die Meere mit ihrer thermischen Trägheit gegangen ist, braucht so lange zum Ausgleich. Daher spielt sie z.B. für die Beantwortung der Frage, ob und wann bis 2100 das politische Ziel der Begrenzung auf 2 Grad C Erwärmung „gerissen“ werden könnte, nicht die vorrangige Rolle. Die TCR ist für diese Belange die aussagefähigere Größe. Sie ist definiert als die Temperaturerhöhung die sich einstellt, wenn pro Jahr 1% mehr Treibhausgase (Green House Gases, GHG) hinzukommen und sich schließlich ihr Niveau gegenüber einem definierten Ausgangswert verdoppelt hat. Sie berücksichtigt den Ausgleich der Meere praktisch nicht.

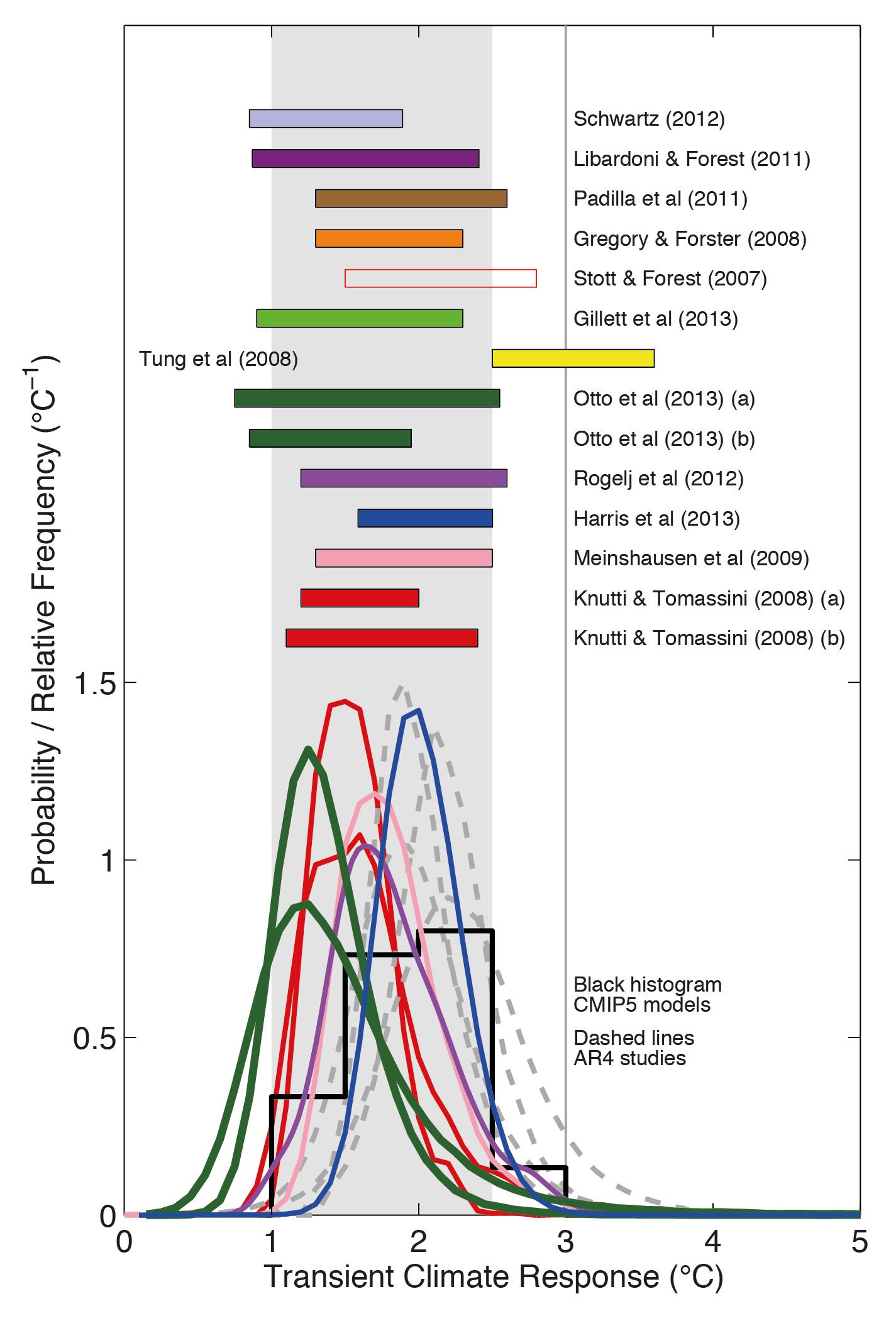

Die direkte Beobachtung der Größe ist kaum möglich, zu viele Einflussgrößen wirken auf unser Klima. Man teilt sie grob ein in Antriebe (Forcings) von außen oder innen (wie die Sonne, Vulkane, Schwebestoffe in der Luft, GHG) und in eine interne Variabilität (wie das El Nino- Geschehen im Pazifik, Ozeanströmungen im Atlantik und Pazifik, Wirkungen der Biosphäre). Das wirkt alles im Chor, und eine Messung der Auswirkung nur einer Größe ist nur sehr schwer möglich. Das IPCC fasste die Bandbreite der möglichen TCR in einem Bild zusammen:

Abb.1: Die Verteilungen der TCR nach der Wahrscheinlichkeit gem. IPCC AR5, Fig.2 Box 12.2 des IPCC- Berichtes von 2013. Im oberen Teil sind die Ergebnisse von Arbeiten zusammengefasst, auch sie bestreichen eine größere Bandbreite.

Unten im Bild sind die Modellresultate (CMIP5) mit aufgeführt, sie liefern ca. 1.9°C/CO2-Verdopplung. Die Langzeituntersuchungen unter Berücksichtigung von jahrhundertelangen Reihen unter Benutzung von fossilen „Stellvertretern“ (Proxy-Daten) für Thermometermessungen kommen oft auf noch höhere Werte für die TCR.

Neuere Arbeiten aus Beobachtungen liefern meist kleinere Werte, eine ganz neue von Nic Lewis und Judy Curry gibt den Bereich von 0,9-2,5 mit der höchsten Wahrscheinlichkeit bei 1,3 an. Ein geschlossenes Bild ist schwierig zu erhalten, die drei beschriebenen Methoden kommen zu sehr unterschiedlichen Resultaten. Momentan wird allen das gleiche Gewicht beigemessen, die deutsche Wikipedia z.B. hält nach wie vor 2,0 für am wahrscheinlichsten und zitiert in diesem Zusammenhang den vorletzten IPCC- Bericht aus 2007. Eine Aktualisierung täte der Seite sicher gut!

Die Ergebnisse der CMIP5- Klimamodelle werden auch heute noch gleichberechtigt zu den Beobachtungen gesetzt. Wir wollen uns hier die Frage stellen, ob dies gerechtfertigt ist. Hierzu verwenden wir die beobachteten Daten seit 1945 nach GISS für die globale Oberflächenmitteltemperatur der Erde (GMST) und die CMIP5- Daten, wie sie hier zur Verfügung gestellt werden. Die Modelle selbst geben verschiedene Szenarien aus, die unterschiedliche Bedingungen simulieren. Für das reine Strahlungsforcing durch GHG genügen jedoch die Mittelwerte (Ensemble-Means), die aus vielen Modellläufen verschiedener Modelle gewonnen werden.

Nun berechnen wir die Steigungen der linearen Trends (minimal 30 Jahre lang) von jedem Jahr an und zwar zum Einen bis 2004 und zum Anderen bis zum aktuellen Jahr 2014. Für den noch nicht 100%ig feststehenden Wert das Jahres wurde der Mittelwert der ausgewerteten Monate Januar-September herangezogen, die Abweichungen bis einschließlich Dezember werden nur wenige hundertstel Grad C betragen.

Abb 2: Die linearen Trendsteigungen von 1945 an bis zum Endjahr 2004 für GISS (braun) und CMIP5 (grün) und bis zum Endjahr 2014 für GISS ( blau) und CMIP5 (violett).

Die Abbildung beleuchtet die Modellprobleme mit der Temperaturentwicklung des letzten Jahrzehnts. Bei den Trends bis 2004 scheint die Welt noch in Ordnung. Die braune und grüne Kurve verlaufen recht gut in Deckung, sie liefern ähnliche Werte für den Temperaturanstieg über ein Jahrhundert. Die Diskrepanz auch rückwirkend wird deutlich, wenn man das aktuelle Jahr als Endzeitpunkt der Trends heranzieht. Die beobachteten Daten erzeugen bemerkenswert stabile Trends seit 1964 mit einer Steigung von 1,6+-0,04 Grad C/ Jahrhundert. Die rückwirkenden Modellwerte dagegen geben Steigungen von 2 -2,5 Grad C/ Jahrhundert aus, die sich signifikant auf dem 95-% Konfidenzniveau (Fehlerbalken in Abb.2) von den Beobachtungen unterscheiden. Man könnte formulieren: Die Modelle geben die beobachtete Wirklichkeit schlicht nicht richtig wieder, und zwar nicht zufällig sondern systematisch. Woran könnte das liegen?

Die CMIP5-Modelle sind wie andere auch ein mathematisch/physikalisches eigenes Universum, sie leben in Rechnern. Es wird alles hinein programmiert, was die Wissenschaft über die Wechselwirkungen zwischen Atmosphäre und Landflächen sowie Ozeanen erforscht hat. Damit dieses Paralleluniversum auch unsere Erde beschreibt, werden die Modelle angepasst an das, was beobachtet wurde. Hierfür muss man einen Zeitraum auswählen und die Parameter entsprechend einstellen. Diesen Vorgang nennt man „Hindcast“. Der gewählte Zeitraum für diesen Vorgang lag im vorliegendem Fall zwischen 1976 und 2005, das wurde in einer Arbeit eines Teams um Thomas Mauritsen vom Hamburger Max-Plack-Institut für Meteorologie erst unlängst beschrieben.

Schauen wir uns diesen Zeitraum in Abb. 2 an: Der Trend der Beobachtungen ging für den Endzeitpunkt des Intervalls seit 1970 deutlich nach oben im Vergleich zu den Vorjahren. Man hat dies sehr wahrscheinlich der GHG-Wirkung zugeschrieben und die Modelle entsprechend getunt. Aber: Die Wirkung einzelner Komponenten (Forcing, interne Variabilität) lässt sich kaum einzeln zuordnen, wie wir oben schon festgestellt haben. Die Schwierigkeiten mit der Ermittlung von TCR wurden auf die Modelle projiziert, indem man einen Zeitraum nutzte, der sehr wahrscheinlich im Rückblick von großer interner Variabilität durch die atlantische Variation (AMO) geprägt war. Dafür spricht, dass der „Buckel“ in den Trends bis 2004 weitgehend wieder eingeebnet wurde, wenn man die Trends bis 2014 (in Abb.2 blau) betrachtet.

So gesehen steht das „Paralleluniversum“ CMIP5 vor einer großen Herausforderung: Es muss die recht großen Abweichungen zu den Beobachtungen erklären, die sich nach 2004 herauskristallisierten. Wie kann das gehen? Auf welchen Wert für TCR müssten die Operationen im Rechner angepasst werden? Das ist nicht so schwer zu ermitteln: Der Mittelwert der Jahrestrendsteigungen nach 1964 bis zur Gegenwart beträgt beobachtet: 1,6°C/Jahrhundert. Die Modelle liefern ím Mittel 2,21, also etwa 28% zu viel. Die TCR (vgl. Abb.1) wird von Modellen bei ca. 1,9 angenommen und müsste um diese 28% reduziert werden. Das ergibt 1,38, auch mit der Temperaturreihe von GISS. Den Wert haben wir schon mal gelesen: bei Lewis/Curry (2014) und anderen aktuellen Arbeiten. Die Modelle liefern also ebenfalls das, was aus Beobachtungen abzuleiten ist, wenn man sie endlich an die Wirklichkeit anpasste. Höchste Zeit also für einen neuen, verbesserten Hindcast von CMIP5. Bis dahin bleibt es unverständlich, warum der IPCC ihnen den Rang bei der Bewertung von TCR zubilligt, den Beobachtungen unseres realen Temperatur-Universums haben, das so gar nicht zu dem passt, was uns die Modelle vermitteln.

Wenn Sie also demnächst wieder etwas lesen, was aus Modellen abgeleitet wurde: legen Sie sich unsere Abbildung 2 neben den Artikel, damit Sie daran erinnert werden, wie stark sich das Rechner-Universum inzwischen von der Realität unterscheidet!