Den wahren Wert einer Vorhersage erkennt man am besten im ehrlichen sportlichen Wettkampf. Man nehme eine Vorhersage, die möglichst zehn, zwanzig oder mehr Jahre alt ist, und vergleiche sie einfach mal mit der in der Natur real registrierten Entwicklung. Wenn alles passt, hat sich das Modell das Vertrauen ehrlich verdient. Falls sich jedoch größere Diskrepanzen ergeben, sollte man sich ernsthaft Gedanken darüber machen, ob das Modell wirklich auf den richtigen Grundlagen basiert. Mit kosmetischen Korrekturen ist es da nicht getan.

Bereits im Juni 2012 haben wir bei uns im Blog einen Gastbeitrag von Prof. Jan-Erik Solheim gebracht, der genau solch einen Theorie-gegen-Praxis-Vergleich unternommen hat (siehe „Was ist eigentlich aus James Hansens Temperaturvorhersage von 1988 geworden? Zeit für eine Überprüfung“). Das Resultat war ernüchternd: Die von der Hansen-Truppe 1988 modellierte Temperaturvorhersage lag um etwa 150% daneben (Abbildung 1).

Abbildung 1: Temperaturprognose der Hansen-Gruppe aus dem Jahr 1988. Die verschiedenen Szenarien gehen von 1,5% CO2-Zunahme (blau), konstanter Zunahme der CO2-Emissionen (grün) und stagnierenden CO2-Emissionen (rot) aus. In der Realität stiegen die CO2-Emissionen um sogar 2,5% an, was einem Szenario oberhalb der blauen Kurve entsprechen würde. Die schwarze Kurve gibt die letztendlich real gemessen Temperatur an (gleitendes 5-Jahresmittel). Die Hansen-Modellierung überschätzt die Temperatur um 1,9°C und liegt damit um satte 150% daneben. Abbildung ergänzt nach Hansen et al. (1988).

Im April 2012 hatten wir uns zudem eine Temperaturprognose von Hartmut Graßl vorgenommen, die er 1990 aufgestellt hatte (siehe unser Blogartikel „Graßl’s Erwärmungsprognose von 1990 droht dramatisch zu scheitern“). Auch hier sieht es überhaupt nicht gut aus. Das Ergebnis der Analyse: Die Temperatur müsste in den kommenden 8 Jahren um satte 0,75°C ansteigen, damit Graßls Vision noch Wirklichkeit wird. Hier sollte wohl Einigkeit über alle Lager hinweg herrschen: Dies ist schlichtweg unmöglich. Eine schöne Zusammenschau der fehlgeschlagenen IPCC-nahen Prognosen ist übrigens auch auf C3 Headlines erschienen.

Anstatt sich nun die notwendigen Gedanken über einen Modellierungsneuanfang zu machen (siehe z.B. Anmerkungen von Roger Pielke, Sr.), wursteln die IPCC-Forscher einfach weiter herum so wie bisher. Offensichtlich lassen sie sich auch nicht dadurch beunruhigen, dass die Modelle weder den Temperaturstop der vergangenen 10 Jahre reproduzieren – geschweige denn vorhersagen – konnten, noch die Klimageschichte der letzten Jahrtausende in den Griff bekommen. So werden wir wohl auch im kommenden 5. Klimazustandsbericht keine Verbesserung erwarten können, wie eine Pressemitteilung der französischen Forschungsorganisation CNRS aus dem Februar 2012 erahnen lässt:

Die französische Wissenschaftsgemeinschaft für Klimafragen hat kürzlich wichtige Simulationen zum vergangenen und künftigen Klima im globalen Maßstab abgeschlossen. Diese aktuellen Daten bestätigen die Ergebnisse des vierten Sachstandsberichts (2007) des Weltklimarats (IPCC) über die kommenden Veränderungen bei der Temperatur und der Niederschlagsmenge. Dabei wurden 2 Extremmodelle berücksichtigt: Ein Temperaturanstieg von 3,5 bis 5°C bis 2100 oder im günstigsten Fall ein Anstieg um 2°C. Von der internationalen Wissenschaftsgemeinschaft zur Verfügung gestellt, werden diese Ergebnisse vom IPCC zur Erarbeitung ihres nächsten für 2013 geplanten Berichts verwendet. […] Es bestätigt sich eine Intensivierung des Wasserkreislaufs und ein schnelles Abschmelzen des arktischen Packeises, das im schlimmsten Fall im Sommer 2040 oder 2060, je nach Modell, verschwunden sein wird. Die Simulationen, die das Klima und den Kohlenstoffkreislauf miteinander in Verbindung setzen, liefern neue Antworten.

Das Gleiche gilt übrigens wohl auch für die Klimawirkung der Sonne, die im neuen IPCC-Bericht offenbar sogar noch weiter heruntergeschraubt wird (siehe unser Blogartikel „Der neue IPCC-Klimabericht: Sonne noch weiter degradiert !“). Entsprechend wird die Klimawirkung des CO2 jetzt weiter nach oben gesetzt. In einer Klimamodellierungsarbeit einer Gruppe um Gerald Meehl, die im Juni 2012 im Journal of Climate erschien, wird jetzt von einer langfristigen CO2-Klimasensitivität von 3,2°C ausgegangen, was 25% höher ist als im Vorgängermodell (siehe Diskussion auf der NIPCC-Webseite).

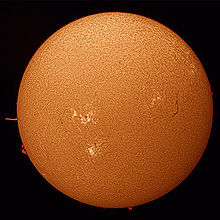

Ein Hauptproblem der diversen Klimamodelle ist die viel zu gering angenommene Klimawirkung der Sonne. Wie können die Temperaturen in den letzten 10.000 Jahren synchron zur Sonnenaktivität pulsiert haben, wenn doch die Sonne eigentlich kaum eine Rolle gespielt haben sollte? Dabei gibt es mindestens drei Stellschrauben, an denen die Modellierer nachbessern könnten. So werden derzeit keinerlei Solarverstärker berücksichtigt (siehe unser Buch „Die kalte Sonne, Kapitel 6). Weder der UV-Verstärker noch der Svensmark-Verstärker über die kosmische Strahlung und Wolken wurden bislang in Klimamodell-Szenarien umgesetzt.

Ein Hauptproblem der diversen Klimamodelle ist die viel zu gering angenommene Klimawirkung der Sonne. Wie können die Temperaturen in den letzten 10.000 Jahren synchron zur Sonnenaktivität pulsiert haben, wenn doch die Sonne eigentlich kaum eine Rolle gespielt haben sollte? Dabei gibt es mindestens drei Stellschrauben, an denen die Modellierer nachbessern könnten. So werden derzeit keinerlei Solarverstärker berücksichtigt (siehe unser Buch „Die kalte Sonne, Kapitel 6). Weder der UV-Verstärker noch der Svensmark-Verstärker über die kosmische Strahlung und Wolken wurden bislang in Klimamodell-Szenarien umgesetzt.