Von Frank Bosse

Eine der Grundlagen für „große Transformationen“ und eine „Entkarbonisierung“ ist der Blick in die Zukunft mit Schaudern. Das Setting ist klar: Wer Verantwortung für kommende Generationen spürt, der muss heute schon schwerwiegende Entscheidungen fällen. Zum Beispiel das Glühlampenverbot. Oder maßlos steigende Stromkosten bei immer unsichereren Netzen. Solche Propheten nach der Methode „Gib mir heute Dein Geld, dann geht es Dir und Deinen Kindern später besser“ gab es, so lange die Menschheit existiert, vom Ablasshandel bis zum real existierenden Sozialismus und bestimmten Versicherungen. Schon in der Bibel steht bei Matthäus: „Seht Euch vor vor den falschen Propheten“.

Manchmal kann man schon früh einem solchen auf die Schliche kommen. Im Jahre 2007 erschien im Wissenschaftsblatt Nummer 1 „Science“ ein Artikel von Doug M. Smith und Kollegen vom britischen MetOffice unter dem Titel:

„Verbesserte Vorhersage der Oberflächentemperaturen für die nächste Dekade mittels eines globalen Klimamodells“

Mit den dargelegten ausgeklügelten Methoden war es das Ziel, unter Beachtung der internen Variabilität des Klimas eine Prophezeiung der Temperaturentwicklung 2004 bis 2014 vorzunehmen. Das Ergebnis damals:

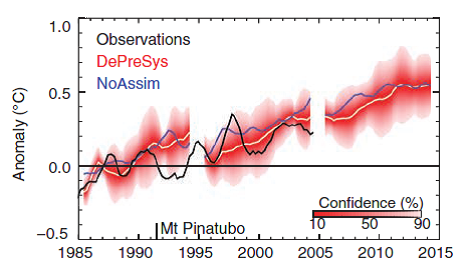

Bild 1: Die dekadische Vorhersage von Smith et al. (2007) für den Zeitraum bis 2014 (Quelle: Bild 4 der o.g. Arbeit)

Im Text ist die Ansage klar und deutlich:

„…predict further warming during the coming decade, with the year 2014 predicted to be 0.30° ± 0.21°C [5 to 95% confidence interval (CI)] warmer than the observed value for 2004. Furthermore, at least half of the years after 2009 are predicted to be warmer than 1998, the warmest year currently on record.“

Nun kann man das ja verifizieren: Die realen Beobachtungen zwischen 1998 und 2014:

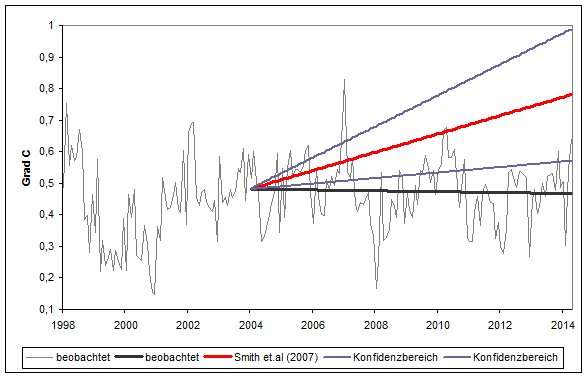

Bild 2: Beobachteter globaler Temperaturverlauf nach der MetOffice -hauseigenen Temperaturreihe HadCRUT4 im Vergleich zu den Aussagen in der o.g. Arbeit.

Der Trend besagt: 0,014°C Abkühlung in der Dekade 2004-2014. Nach 2009 war kein Jahr wärmer als 1998: Für die Erfüllung der Prophezeiung hätten es drei sein müssen. Eine andere Temperaturreihe (GISS) misst ganze 0,03 Grad Erwärmung, selbst damit ist auch der untere Konfidenzbereich der Vorhersage unterschritten. Unmittelbar nach Veröffentlichung der Arbeit war man sich jedoch sicher, den Nagel auf den Kopf getroffen zu haben und das Schaubild 1 erschien unter anderem in einem Bericht mit dem Untertitel: „Zukunftsinformationen für die Politik der Regierung“. Da las man, dass gute dekadische Vorhersagen für Politik und Wirtschaft sehr nützlich sind ( S. 6) … solange sie ignoriert werden, könnte man hier anfügen.

Ein Fiasko. Man hat die Politik falsch informiert. Woran kann es gelegen haben? Jedes Klimamodell hat eine große Anzahl Freiheitsgrade, die man einstellen muss. Dazu dienen Beobachtungen, mit denen die Modelle feinjustiert werden: die jüngere Vergangenheit wird benutzt, um die Klimamodelle zu parametrieren, man nennt das „Hindcast“. Außerdem setzt man voraus, dass in kürzeren Zeitskalen das Klima in erster Näherung linear auf zwei Einflüsse reagiert: ein äußerer Antrieb (Forcing, vor allem durch Treibhausgase wie CO2) und eine interne Variabilität.

Und genau da liegt der Hase im Pfeffer. Bis heute hat man seit dem ersten Klimabericht des IPCC 1990 keinerlei Fortschritt in einem zentralen Punkt für Klimaprognosen gemacht: Wie viel Grad Celsius Erwärmung zieht eine Verdopplung der CO2- Konzentration in der Luft nach sich? Die Bandbreite der Möglichkeiten ist im letzten Bericht 2013 noch genauso groß wie vor 23 Jahren. Für (klimatisch relativ kurze) Zeiträume von 10 Jahren ist die TCR (Transient Climate Response) entscheidend und die liegt seitdem zwischen 0,8 und 2,5 Grad Celsius. Man kann seitens der Klimaforschung die Klimawirkung des CO2 , auf das ja die Politik ganz schnell mit möglichst großer Wirkung reagieren soll, nicht genauer quantifizieren als ganz zu Beginn der IPCC- Geschichte. Wer eine aktuelle Diskussionsrunde zum Thema „Klimasensivität“ verfolgt, bekommt eine Eindruck davon, welch unterschiedliche Ansätze gegenwärtig betrachtet werden.

Wenn also ein Modell- um auf das 2007er-Fiasko des britischen MetOffice zurückzukommen- anhand einer Zeitspanne feinjustiert wird, indem die interne Variabilität (z.B. ozeanische Strömungen) sehr viel zum Anstieg der Temperaturen beigetragen haben, dann wird es die Zukunft falsch prophezeien indem die stattgefundene Erwärmung auf das Forcing zurückgeführt wird. So ging es den verwendeten Modellen in der Arbeit aus 2007. Der Hindcast des 20. Jahrhunderts sollte den Forecast des 21. Jahrhunderts meistern und versagte kläglich, weil die natürliche Variabilität offensichtlich nicht auch nur im Ansatz realitätsnah berücksichtigt wurde.

Daraus könnte man lernen… und die Treibhausgaswirkung in Modellen zurücknehmen… jedoch: woher weiß man genau, wie gerade die interne Variabilität wirkt? Man kennt weder diese genau noch die CO2- Wirkung. Wie sinnvoll sind dann Modelle? Nun, die Anwender sind weiterhin optimistisch. Der gleiche Leadautor wie in der besprochenen Arbeit aus 2007 hat voriges Jahr eine neue geschrieben. Der internen Variabilität wird da etwas mehr Aufmerksamkeit geschenkt und die Prophezeiung ist vorsichtiger (und durch die Bandbreite mehr oder weniger nutzlos):

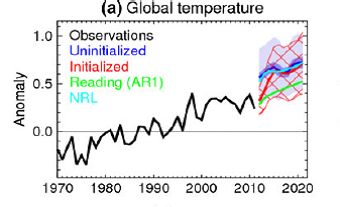

Bild 3: Vorhersage der globalen Temperatur bis 2022 (Bild 8 der o.g. Arbeit)

Bei Licht besehen bleibt es ein Herumgestochere im Nebel, solange man so richtig sicher nur weiß: wachsende Konzentrationen von Treibhausgasen führen zu Erwärmung. Nur wie viel? Bis man die Anteile der natürlichen Variabilität am beobachteten Klimageschehen nicht mit der notwendigen Genauigkeit bestimmen kann, bleibt die Berechnung der Wirkung von Treibhausgasen auch Prophetie. Haben Sie ein schlechtes Gewissen beim Benutzen der „gebunkerten“ Glühlampen? Ersparen Sie es sich!