Von Eike Roth

KURZFASSUNG

Weltweit sind Ziele für den „Klimaschutz“ festgelegt worden, insbesondere im Pariser Klima-Abkommen. In diesem Beitrag wird untersucht, wie weit diese Ziele sachlich begründet sind und wie sie optimiert werden können. Der Verlauf der global gemittelten Temperatur wird mit dem der CO2-Konzentration verglichen, Übereinstimmung und Unterschiede werden herausgearbeitet und es wird versucht, diese zu begründen und zu erklären. Die Zuverlässigkeit und Aussagekraft von Klimamodellen wird untersucht und bewertet. Mögliche Beiträge anderer Ursachen zur Klimaentwicklung werden diskutiert. Die in Deutschland beschlossenen Maßnahmen zum Klimaschutz werden hinsichtlich ihrer Erfolgschancen überprüft. Als Ergebnis werden viele offene Fragen identifiziert.

ABSTRACT

Goals for climate protection have been established globally, particularly in the Paris Climate Agreement. This paper analyzes the reasons behind and how to optimize the goals. The development of global temperatures is checked against the concentration of carbon dioxide, matches and discrepancies are identified and reasons and explanations are discussed. Reliability and validity of climate models are examined and assessed. Possible contributions of other causations to global warming are examined. Climate protection measures Germany has decided on are checked regarding their chances of success. As a result, a lot of open questions are identified.

Über den Autor:

Eike Roth, Jahrgang 1941, studierte Experimentalphysik an der Uni Wien, Promotion 1967. Berufliche Tätigkeit im Kernenergiegebiet, zuletzt als Technischer Leiter des Kernkraftwerkes Mülheim Kärlich in der Nähe von Bonn. 2001 pensioniert. Seit 40 Jahren intensive Beschäftigung mit Energie- und Umweltfragen und dem Klimaproblem, einschlägige Vorlesungen, Fachveröffentlichungen und populärwissenschaftliche Bücher.

————————

Vorbemerkungen

Beim Klima ist die Welt gespaltener denn je. Auf der einen Seite werden die Warnungen vor anthropogenen Klimaänderungen immer drastischer. Wir müssten sofort und durchgreifend handeln, auch wenn das schwer fällt. Darüber sei sich die Wissenschaft einig. Wir müssten unsere Anstrengungen sogar verdreifachen. Auf der anderen Seite gibt es immer mehr Skepsis. Trump hat den Austritt der USA aus dem Pariser Klimaabkommen beschlossen, der neu gewählte Präsident Bolsonaro in Brasilien hat ihn angekündigt und andere Länder könnten folgen. Fast überall wächst der Widerstand gegen teure Klimaschutzmaßnahmen. In Frankreich hat er bereits zu gewalttätigen Protesten geführt. Viele Menschen sehen andere Probleme als wichtiger an.

In der veröffentlichten Meinung wird die Einigkeit der Wissenschaft immer wieder betont. Hält das einer Überprüfung stand? In diesem Beitrag möchte ich auf 4 Problembereiche näher eingehen, bei denen meiner Meinung nach noch ganz erheblicher Diskussionsbedarf besteht. Vielleicht könnte die Klärung dieser Punkte die Diskrepanz zwischen den beiden Seiten verkleinern.

- Klimaoptimum: Wo liegt dieses tatsächlich? Wie weit dürfen wir es überschreiten?

- Gegenrechnung: CO2 ist auch nützlich (erhöht das Pflanzenwachstum) und zu viel Klimaschutz ist auch schädlich (erschwert die Lösung anderer Probleme). Wo liegt das Gesamt-Optimum?

- Klimamodelle: Wie gut sind die und wie belastbar sind ihre Ergebnisse?

- Gegenmaßnahmen: Wie wirksam sind die beschlossenen? Können sie überhaupt Erfolg haben?

Als Ergebnis wird sich zeigen, dass tatsächlich vielfach noch weitere Überlegungen und Forschungen notwendig sind, um dann mit mehr Klarheit zielgerichtet die richtigen Entscheidungen treffen zu können. Anderenfalls sind mit hoher Wahrscheinlichkeit Misserfolge zu erwarten. Allem Anschein nach befinden wir uns auf geradem Weg dorthin.

1 Wo liegt das Klimaoptimum tatsächlich?

Klimageschichte

„Klima“ ist der langjährige (meist 30 Jahre) Mittelwert von Wetterdaten. Sein Wesensmerkmal ist der Wandel. Geändert hat es sich schon immer, es ändert sich jetzt und es wird sich auch in der Zukunft ändern. Bekannt sind vor allem die Wechsel zwischen Warm- und Eiszeiten in etwa 100000-jährigem Rhythmus (wobei – wenn man die Geschichte fortschreiben darf – der nächste Wechsel langsam fällig wird, denn die Warmzeiten waren immer viel kürzer als die Kaltzeiten).

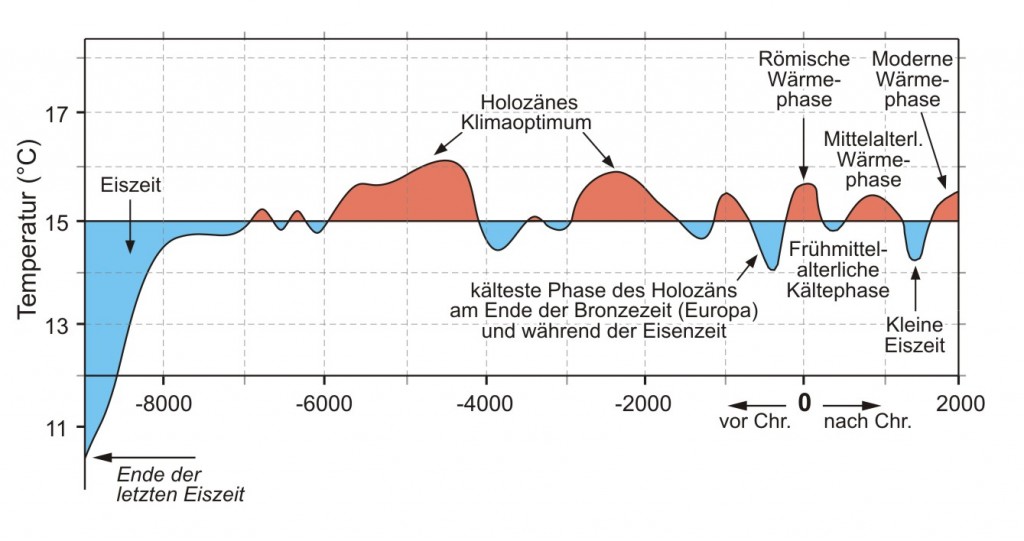

Aber auch in der jetzigen Warmzeit gab es erhebliche Klimaschwankungen. Abb. 1 zeigt die Temperaturentwicklung. Man sieht insbesondere viererlei:

- Erstens ein dauerndes Auf und Ab.

- Zweitens nichts Besonderes am Ende des Betrachtungszeitraumes (hierzu später mehr mit verbesserter Auflösung).

- Drittens in den letzten ca. 4000 Jahren einen deutlich ausgeprägten Zyklus mit einer Warmperiode etwa alle 1000 Jahre ohne insgesamt steigende oder sinkende Tendenz.

- Viertens noch etwas wärmere Phasen vor ca. 4500 und 7000 Jahren.

Als Ursache für diese Veränderungen kommen wohl nur Schwankungen der Intensität der Sonne und der Parameter der Erdumlaufbahn um die Sonne in Frage, unterstützt vielleicht noch durch langfristige Änderungen der Meeresströmungen und der Vulkanaktivität. Der Mensch hatte in dieser Zeit sicher noch keinen Einfluss auf das (globale) Klima.

Abb. 1.: Entwicklung der global und jahreszeitlich gemittelten, bodennahen Lufttemperatur der Erde seit dem Ende der letzten Eiszeit. Quelle: Fritz Vahrenholt, Sebastian Lüning: „Die Kalte Sonne“, ISBN 978-3-455-50250-3, nach Kehl, H. (2008) „Das zyklische Auftreten von Optima und Pessima im Holozän“, http://lv-twk.oekosys.tu-berlin.de/project/lv-twk/002-holozaene-optima-und-pessima.htm.

Prinzipiell ist dieser Temperaturverlauf seit langem bekannt. Aus der Geschichte weiß man auch, dass es der Menschheit insgesamt in den warmen Zeiten immer besser gegangen ist als in den kalten. So hat z. B.

- das „Römische Klimaoptimum“ die kulturelle Blüte und den Aufstieg des Römischen Weltreiches begünstigt

- die Kaltzeit danach vermutlich wesentlich die Völkerwanderung mit verursacht und dadurch zum Untergang dieses Reiches beigetragen

- das mittelalterliche Klimaoptimum einen Aufschwung in Europa, die Besiedelung von Island und Grönland und die ersten Fahrten nach Amerika (als “Vinland“ bezeichnet) mit sich gebracht und

- die „Kleine Eiszeit“ danach zu weit verbreitetem Hunger und Elend in Europa (und damit ganz wesentlich zur Auswanderung nach Amerika) beigetragen.

Folgerichtig hat man die wärmeren Zeiten immer schon als „Klimaoptimum“ bezeichnet. Dabei wissen wir gar nicht, ob diese Bezeichnung überhaupt berechtigt ist. Es waren zwar die warmen Zeiten immer besser als die kalten, ob aber „noch etwas wärmere Zeiten“ nicht „noch bessere Zeiten“ gewesen wären, wissen wir nicht, da fehlt uns ganz einfach die Erfahrung. Bei Rückschlüssen aus den beiden „holozänen Klimaoptima“ (Abb. 1) mit tatsächlich höheren Temperaturen ist Vorsicht geboten, weil die Informationen aus so alter Zeit spärlich sind. Aber immerhin hatte sich die Menschheit damals gewaltig weiterentwickelt und die Sahara war damals fruchtbares Grünland. „Noch besser“ bei „noch wärmer“ ist daher keineswegs abwegig.

Zwischenergebnis: Wo das Klimaoptimum liegt, wissen wir nicht. In den 400 Jahren seit dem Höhepunkt der Kleinen Eiszeit ist es zweifelsfrei wärmer geworden. Der Rückgang der Gletscher in den letzten 150 Jahren macht das für Jedermann ersichtlich. Aber die Erfahrung sagt uns, dass das gar nicht so schlecht ist. Der Menschheit insgesamt ist es immer umso besser gegangen, je wärmer es war. Ob das auch über das heutige Niveau hinaus noch so weiter geht, wissen wir nicht. Wir wissen auch nicht, wie rasch es bei Überschreiten des Optimums wieder schlechter wird. Hier besteht dringender Forschungsbedarf.

Zielvorgaben

Trotz dieser Unsicherheiten hat die Politik im Pariser Klimaabkommen von 2015 bekanntlich vereinbart, die globale Erwärmung auf „deutlich unter 2 Grad gegenüber dem vorindustriellen Wert“ zu begrenzen, besser sogar auf „unter 1,5 Grad“. „Vorindustriell“ bezieht sich dabei auf die Zeit um 1850 herum. Damals war es zwar schon geringfügig wärmer als am Höhepunkt der Kleinen Eiszeit (ca. 1650), aber noch weit unter dem, was bisher als „Optimum“ bezeichnet wurde. Auf solch ein historisch ermitteltes „Optimum“ bezogen, heißt die Pariser Vereinbarung, dass dieses nur um weniger als 1 Grad überschritten werden darf, besser sogar um weniger als 0,5 Grad. Welche Berechtigung gibt es für diese scharfe Grenze?

Ich möchte diese Frage noch etwas zuspitzen: Von den „zulässigen“ 2 Grad bzw. 1,5 Grad haben wir 1 Grad schon erreicht (siehe Kap. 3). Mit diesem Erreichen einher ging eine wesentliche Erhöhung unseres Lebensstandards, eine erhebliche Verbesserung unserer Gesundheit, fast eine Verdoppelung unserer Lebenserwartung und eine deutliche Abnahme von Hunger und Elend in der Welt trotz stark wachsender Bevölkerung. Natürlich haben viele Faktoren zu dieser Entwicklung beigetragen, aber aus der gesamten geschichtlichen Entwicklung wissen wir, dass die eingetretene Erwärmung um 1 Grad mitgeholfen hat, dieses hochwillkommene Ergebnis zu erreichen. Diese Erwärmung war ganz eindeutig gut und wir sollten uns über sie freuen. Jetzt jedoch sollen wir plötzlich enorme Anstrengungen unternehmen, um eine weitere Erwärmung um auch nur ein halbes Grad zu vermeiden? Sonst würden Katastrophen ungeahnten Ausmaßes drohen? Da müssen schon gute Argumente her! Sehen wir sie uns an.

Kipperscheinungen

Die Zielsetzungen von Paris sind, wie gesagt, politische Festlegungen. Eine wissenschaftlich fundierte, quantitative Begründung für gerade diese Grenzwerte ist im Abkommen nicht enthalten. Auch in der sonstigen Literatur konnte ich eine solche nicht finden. Die Grenzwerte werden vielmehr – wenn überhaupt – stets nur mit qualitativen Argumenten begründet. Aber selbst die Qualität scheint mir zum Teil diskussionswürdig zu sein.

Vielfach werden mögliche Kipperscheinungen im Klimasystem zur Begründung der niedrigen Zielwerte angeführt. Z. B. könnten Permafrostböden in Sibirien und Nordamerika infolge der Erwärmung auftauen und dabei große Mengen Methan freisetzen, das seinerseits ein starkes Treibhausgas ist und damit den Treibhauseffekt irreversibel so sehr verstärken könnte, dass die Erde dann für Menschen unbewohnbar wird. Solche Effekte sind zwar prinzipiell theoretisch möglich (wie generell vieles theoretisch möglich ist), aber eine nachvollziehbare Argumentation, bei welcher (absehbaren!) Entwicklung ein solcher Effekt tatsächlich zu erwarten ist, ist m. E. nirgends zu finden. Er bleibt eine theoretische Möglichkeit, mit deren Eintreten in der Praxis nicht gerechnet werden muss.

Diese ablehnende Bewertung wird durch Beobachtungen und eine grobe Quantifizierung unterstützt: Vor rund 5000 Jahren war es deutlich wärmer als heute (Abb. 1) und in noch viel weiter zurück liegenden Zeiten war es sogar viel wärmer. Es gab sogar Zeiten, in denen beide Pole der Erde völlig eisfrei waren (dann war wohl auch sämtlicher Permafrost aufgetaut, mit Ausnahme vielleicht auf ein paar wenigen hohen Bergen). Anzeichen dafür, dass es dabei jemals zu solchen Kipperscheinung mit Weglaufen des Klimasystems in Richtung unbewohnbar heißer Erde gekommen wäre, gibt es keine (jedenfalls habe ich nirgends welche beschrieben gefunden). Warum sollte so etwas jetzt bei sehr viel kleineren Änderungen bevorstehen? Außerdem wird durch die Erwärmung in überschaubarer Zeit sicher nicht der gesamte Permafrostboden auftauen, sondern er wird nur etwas kleiner werden. Zusätzlich wird im etwa gleichen Ausmaß die Waldgrenze weiter polwärts vorrücken. Wald speichert aber viel CO2. Die Klima-Rückwirkung aus dem tauenden Permafrost dürfte sich daher eher in Grenzen halten (und auch die Sahara könnte wieder grün werden und nochmals CO2 speichern, siehe oben). Die Gefahr wird wahrscheinlich ganz wesentlich überschätzt.

Es werden noch andere mögliche Kipperscheinungen im Klima diskutiert, die sind m. E. aber auch nicht wahrscheinlicher. Wenden wir uns daher nochmals der Vergangenheit zu, vielleicht können wir aus ihr lernen: Der einzige bekannte Vorgang, der eventuell als „Kippen“ bezeichnet werden könnte, ist der Wechsel zwischen Warm- und Eiszeiten. Von unserer jetzigen Warmzeit aus kann das Klima daher möglicherweise in eine Eiszeit „kippen“ (wird es eventuell auch in nicht allzu ferner Zukunft tun), aber ein Kippen in eine lebensfeindliche Heißzeit hat es, wie gesagt, noch nie gegeben. Kipperscheinungen taugen nicht zur Begründung der niedrigen Temperaturgrenzwerte.

Extremwetterereignisse

Ein weiteres immer wieder (qualitativ!) vorgebrachtes Argument für die genannten Temperaturgrenzen sind erwärmungsbedingte Zunahmen von Extremwetterereignissen. Abgesehen von fälschlicherweise als Beweis hierfür ausgegebenen Einzelereignissen (die immer „Wetter“ und niemals „Klima“ sind) wird das mit dem temperaturabhängig höheren Energie- und Wasserdampfgehalt der Luft begründet. Dadurch sollten Extremwetter durch die Erwärmung begünstigt werden. Dem steht aber entgegen, dass die Hauptantriebskraft für das Wetter auf der Erde örtliche Temperaturunterschiede sind, und weil beim Treibhauseffekt die Pole stärker wärmer werden als der Äquator, nehmen diese Temperaturunterschiede im globalen Maßstab mit zunehmendem Treibhauseffekt ab. Das sollte eher wetterberuhigend wirken. Was überwiegt, kann heute wohl niemand seriös beantworten.

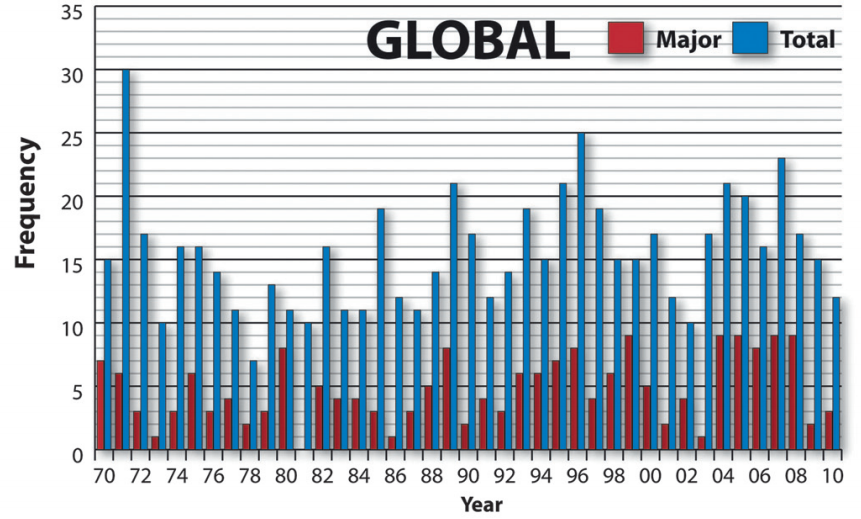

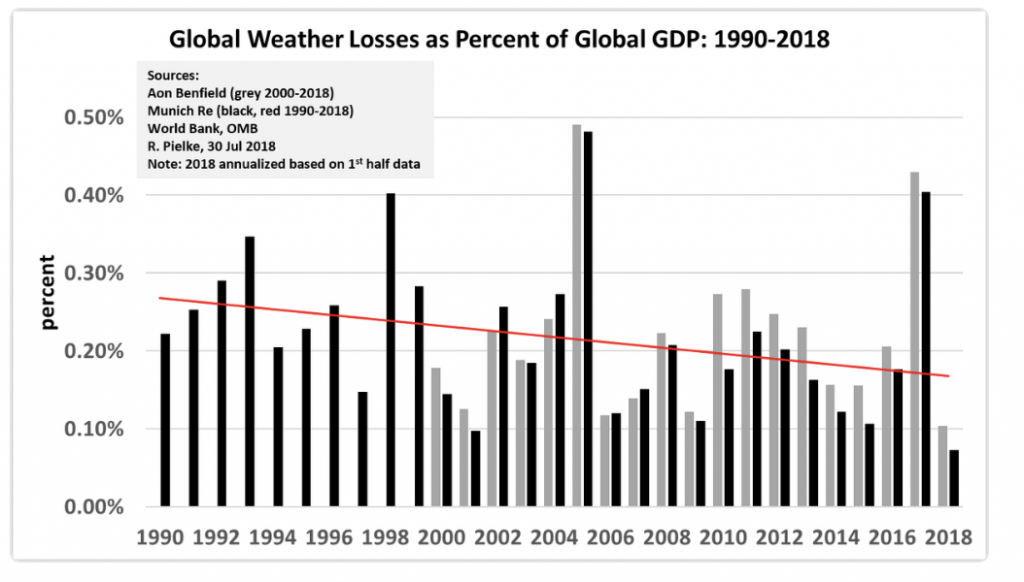

Folglich hilft die Theorie nicht weiter, man ist vielmehr auf Beobachtungen angewiesen. Aber, wie gesagt, nicht auf Einzelereignisse, sondern auf (möglichst globale) Zeitanalysen. Zwei solche möchte ich beispielhaft herausgreifen: Tropische Wirbelstürme und monetäre Schäden durch Wetterkatstrophen. Bei beiden wird immer wieder gesagt, sie hätten in letzter Zeit zugenommen. Dadurch wäre, so heißt es weiter, auch der Beweis für die sich anbahnende Katastrophe durch die anthropogene Klimaerwärmung erbracht.

Faktencheck: In Abb. 2 ist die Zahl der weltweit landfallenden tropischen Wirbelstürme von 1970 bis 2010 und in Abb. 3 sind die von 1990 bis heute durch Wetterkatastrophen jeglicher Art insgesamt verursachten Schäden wiedergegeben. Abb. 2 zeigt keine signifikante Tendenz, Abb. 3 zeigt eher einen Abfall. Die behauptete Zunahme stimmt ganz einfach nicht und damit ist auch der angebliche Beweis hinfällig. Man muss eben die Statistik ansehen und darf nicht aus Einzelereignissen schließen.

Abb. 2: Globale Häufigkeit tropischer Wirbelstürme 1970 bis 2010. Erfasst sind alle Wirbelstürme, die bei Landfall Hurrikanstärke hatten (Windgeschwindigkeit für mindestens 1 Minute ≥ 64 Knoten, schwere Hurrikane ≥ 96 Knoten). Quelle: J. Weinkle et al. „Historical Global Tropical Cyclone Landfalls“, Journal of Climate, Vol. 25, Juli 2012.

Abb. 3: Globale Schäden durch Wetterkatastrophen 1990 bis 2017, zur Vergleichbarkeit über die lange Zeit gemessen in Prozent des jeweiligen globalen Bruttoinlandproduktes. Quelle: Roger Pielke, bei GWPF, The Observatory, Eintrag vom 31. Juli 2018.

Das sind 2 Beispiele, es gibt noch viel mehr Beobachtungen mit stets gleichem Ergebnis. Ich habe eine einzige Ausnahme gefunden, bei der es tatsächlich eine statistisch signifikante globale Zunahme gibt: Die Zahl der warmen Tage ist größer geworden. Aber das ist bei einer Erwärmung (die wir zweifelsfrei bis etwa Ende des letzten Jahrhunderts hatten und danach ist es zumindest sehr warm geblieben, siehe Kap. 3) eine triviale Begleiterscheinung und sagt nichts darüber aus, ob sich das Wetter insgesamt in Richtung extremerer Ereignisse verschoben hat. Dass dies Argument überhaupt als „Beweis“ für die Zunahme von Extremwetterereignissen vorgebracht wird, ist für mich ein Indiz dafür, dass stichhaltige Hinweise auf so eine Zunahme fehlen.

Meeresspiegelanstieg

Als letztes Argument zum Thema Temperatur-Grenzwerte möchte ich noch auf den Meeresspiegel eingehen. Vor dessen Ansteigen wird ja immer wieder gewarnt. Generell ist der Meeresspiegel in Warmzeiten – auch in der heutigen! – um gut 100 m höher als in Eiszeiten, weil in denen viel Wasser in Gletschern gespeichert ist. Er ist auch seit der letzten Eiszeit langsam weiter angestiegen. Zurzeit steigt er – mit starken regionalen Unterschieden – um ca. 2 bis 3 mm pro Jahr an. Die Gründe hierfür sind vielfältig und nur zum Teil verstanden. Erwärmung mit dadurch bedingter Ausdehnung des Meerwassers und Abschmelzen von Landeis gehören jedoch zweifelsfrei dazu (Meereis schwimmt und sein Schmelzen verändert den Meeresspiegel daher nicht).

Die heutigen Gebirgsgletscher sind zu klein, um einen großen Einfluss auf den Meeresspiegel haben zu können. Aber das Antarktiseis und das Grönlandeis sind riesig. In der Antarktis ist die Situation zweigeteilt: Auf der antarktischen Halbinsel scheint das Abschmelzen gegenwärtig zu überwiegen, auf dem sehr viel größeren antarktischen Kontinent wächst das Eis jedoch ziemlich eindeutig. Bei Temperaturen immer noch weit unter dem Nullpunkt und mehr Niederschlag ist das auch plausibel. Die Gesamtbilanz der Antarktis ist wohl klar positiv. Sogar so stark, dass nach Meinung mancher Forscher die globale Landeisbilanz derzeit positiv ist.

Schwieriger ist es in Grönland, da sind die Aussagen stark widersprüchlich. Insbesondere in den letzten Jahren wird nicht nur über ein Schrumpfen, sondern manchmal auch über ein Wachsen des Eises berichtet. Von manchen Autoren wird allerdings befürchtet, dass unser heutiges Tun einen unumkehrbaren Abschmelzprozess einleiten könnte. Dadurch würde der globale Meeresspiegel um ca. 7 m steigen und zahlreiche Länder und Städte überfluten. Aber selbst wenn eine solche Entwicklung tatsächlich kommen sollte, würde sie auf jeden Fall viele Jahrtausende brauchen (und dann in Konkurrenz zur nächsten Eiszeit stehen, die nach Erfahrung langsam fällig werden könnte, aber das ist ein anderes Thema). Bei einem Prozess, der viele Jahrtausende braucht, sind kurzfristige Maßnahmen auf keinen Fall erforderlich. Ein solches Problem zu lösen, sollten wir besser unseren Fähigkeiten in 1000 Jahren überlassen.

Kurzfristige Maßnahmen braucht man aus ganz anderen Gründen: Man braucht sie z. B. gegen Überschwemmungen, die durch Sturmfluten und dergleichen ausgelöst werden. Die sind ein reales Problem. Regelmäßig sehen wir entsprechende Bilder aus Bangladesch, Indien und anderen – vornehmlich armen – Küstenländern über den Bildschirm flimmern. Dagegen muss man etwas tun, unabhängig von einer wachsenden oder sinkenden Häufigkeit. Was zu tun ist, das haben andere – wohlhabendere – Länder gezeigt. So wurden beispielsweise in Holland erfolgreich Deiche gebaut. Ich kenne keine statistischen Werte, aber typische starke Sturmfluten in überschwemmungsgefährdeten Gebieten könnten vielleicht bei etwa 5 m Höhe liegen. So hoch muss man dann die Deiche bauen. Ein solcher Deich muss nach vielleicht 100 Jahren neu gebaut oder zumindest generalsaniert werden. Wenn der Meeresspiegel – aus welchem Grund auch immer – um 3 mm pro Jahr steigt, muss man den neuen Deich dann eben nicht 5 m hoch bauen, sondern 5,30 m hoch. Außerdem muss man vielleicht wo anders, wo man früher keinen Deich gebraucht hat, dann einen 30 cm hohen Deich bauen. Das sind die Auswirkungen des Meeresspiegelanstieges! OK, das kostet Geld und verlangt vielleicht weltweite Solidarität, rechtfertigt aber wohl keinesfalls eine völlige Umstellung unseres Energiesystems, wie sie zum Schutz des Klimas häufig gefordert wird.

Zwischenergebnis

Gute Argumente für das 2-Grad-Ziel (bzw. 1,5-Grad-Ziel) konnte ich nirgends finden. Nachvollziehbare quantitative Begründungen scheint es gar nicht zu geben und die üblichen qualitativen Begründungen sind m. E. nicht überzeugend. Vermutlich war die Politik seinerzeit einfach der Ansicht, man müsse ein griffiges Ziel mit einer einfachen Zahl vorgeben, wenn man etwas bewegen will. Das hat die Politik dann auch getan. Zwei Grad hat sie vermutlich gewählt, weil damit das Problem ernst aber doch noch steuerbar erscheint. Wieweit ihr dabei von Anfang an bewusst war, dass durch den gemachten Bezug auf die vorindustrielle Zeit de facto nur mehr ein sehr kleiner Abstand zu Klimazuständen besteht, die bisher als „optimal“ bezeichnet wurden, kann ich nicht sagen. Vielleicht war die Schärfe des Ziels auch nur ein Zufallsprodukt, aber zurück will natürlich keiner.

Die später vorgenommene zusätzliche Verschärfung auf 1,5 Grad scheint mir vor allem dem empfundenen Druck geschuldet zu sein, das Klimaproblem immer drastischer darstellen zu müssen, um das Interesse daran aufrecht zu erhalten. Möglicherweise haben auch die zum Teil rückläufigen Erwärmungsprognosen den Wunsch nach einer Zielverschärfung befördert, um das Problem nicht schrumpfen zu lassen. Einen sachlichen Grund für diese Verschärfung kann ich jedenfalls nicht erkennen.

Die bisherigen Grenzwerte sind also weitgehend willkürlich. Um seriös eine angemessene Grenze für die zulässige Klimaerwärmung angeben zu können, sind m. E. intensive Forschungsanstrengungen zu zwei Fragen dringend erforderlich:

- Wo liegt das Klimaoptimum tatsächlich?

- Wie sehr verschlechtern sich die Lebensbedingungen, wenn das Klimaoptimum überschritten wird?

Solange hierzu nicht ausreichende gesicherte Erkenntnisse vorliegen, fehlt dem Klimaschutz das Fundament. Was auch immer man fordert oder tut, man kann nicht sicher sein, dass es das Richtige ist – es könnte auch genau das Falsche sein.

2 Gegenrechnung

Nutzen von CO2

Alles Leben auf der Erde beginnt mit Pflanzen, die mit Hilfe von Sonnenlicht Kohlehydrate herstellen („Fotosynthese“). Aber das können sie nur, wenn sie neben Wasser auch CO2 als Baumaterial zur Verfügung haben. Je mehr, desto besser können sie es. CO2 mag als Treibhausgas ein Schadstoff sein (hierzu Kap. 3), für das Leben ist es unbestreitbar ein Nutzstoff, mehr noch, für das Leben ist es schlichtweg unentbehrlich.

Dass die Fotosynthese bei mehr CO2 in der Luft besser läuft, ist nicht nur graue Theorie, sondern wird tagtäglich in großindustriellem Maßstab ausgenutzt: Viele Gewächshäuser werden gezielt mit CO2 begast, um die Erträge zu steigern. Das Gleiche funktioniert natürlich auch in der freien Natur: Mit mehr CO2 wächst mehr (je nach Randbedingungen unterschiedlich ausgeprägt, „mehr“ aber wohl immer). Als Folge davon ist z. B. die Gesamt-Biomasse auf der Erde in den letzten 50 Jahren klar gewachsen. Die durch die erhöhte CO2-Konzentration bedingte Produktivitätssteigerung war so stark, dass sie die anthropogene Regenwaldvernichtung und Landschaftsversiegelung sogar überkompensiert hat! Sollen wir uns vor dem CO2 wirklich fürchten?

Auch die Welt-Nahrungsmittelproduktion ist in den letzten 50 Jahren deutlich gestiegen, und zwar klar schneller als die Bevölkerung gewachsen ist. Natürlich gibt es immer noch viel zu viel Hunger und Elend auf der Welt, aber eindeutig weniger als vor 50 Jahren. Unbestreitbar ist ein Teil dieser Verbesserung auf verbesserte landwirtschaftliche Techniken zurück zu führen und auch andere Faktoren haben selbstverständlich eine Rolle gespielt. Aber ebenso unbestreitbar ist ein erheblicher Teil der Verbesserung der erhöhten CO2-Konzentration geschuldet, die Pflanzen einfach hat schneller wachsen lassen. In den letzten 50 Jahren hat CO2 über die verstärkte Fotosynthese zweifelsfrei Menschenleben gerettet, wahrscheinlich millionenfach, während zusätzliche Opfer aufgrund seiner Klimawirksamkeit bisher höchstwahrscheinlich keine eingetreten sind. Sollen wir uns vor dem CO2 wirklich fürchten?

Die positiven Wirkungen von mehr CO2 (verstärktes Pflanzen-Wachstum) sind so gravierend, dass sie angemessen mit den negativen Wirkungen (Klima) verrechnet werden müssen. Das scheint mir ethisch dringend geboten zu sein.

Schaden durch Klimaschutz

Maßnahmen zur Reduzierung der anthropogenen CO2-Freisetzungen kosten Geld, viel Geld sogar. Wäre das nicht so, bräuchte man zu ihrer Umsetzung keine mühsam ausgehandelten internationalen Verträge mit Zwängen und komplizierten Überprüfungsmaßnahmen. Dieses Geld fehlt dann zur Lösung anderer Probleme. Das Reduzieren der Klima-Folgen wird durch die Zunahme anderer Folgen erkauft, ob wir das zur Kenntnis nehmen wollen oder nicht.

Vieles wäre zu diskutieren, ich möchte mich hier auf die Bekämpfung von Hunger und Elend in der Welt beschränken. Bei anderen Problembereichen stellen sich im Detail andere Fragen, das Ergebnis ist aber prinzipiell das Gleiche.

Zwischen „Klimaschutz“ und „Hunger und Elend“ gibt es nicht nur den allgegenwärtigen Konkurrenzkampf um das liebe Geld (was der eine bekommt, geht dem anderen ab), sondern auch eine direkte Wechselwirkung: Diese erfolgt über das Bevölkerungswachstum. Mehr Menschen auf der Erde brauchen nicht nur mehr Nahrungsmittel (und andere Ressourcen), sondern auch mehr Tätigkeiten, bei denen CO2 freigesetzt wird. Mehr Menschen erschweren es also, die CO2-Freisetzungen klein zu halten.

Das Bevölkerungswachstum einzudämmen, sollte daher ein dringendes Anliegen des Klimaschutzes sein. Wie die Erfahrung zeigt, erreicht man eine solche Eindämmung am besten durch Anheben des Lebensstandards. Das wiederum erreicht man, wie ebenfalls die Erfahrung zeigt, am besten durch billige, für jedermann und möglichst jederzeit verfügbare Energie.

In den industrialisierten Ländern ist die Entwicklung jedenfalls genau so verlaufen: Mit der Energieverfügbarkeit für jedermann und zu jeder Zeit stieg der Lebensstandard gravierend an und mit ihm sank das Bevölkerungswachstum drastisch ab, zum Teil sogar bis ins Negative (und dass die Menschen in diesen Ländern heute gesünder und länger leben als je zuvor, sollte auch nicht vergessen werden!). Wenn wir durch Klimavorschriften den Entwicklungsländern diesen Weg verbauen, werden wir aller Voraussicht nach nicht nur Hunger und Elend vergrößern, sondern es werden zukünftig auch mehr Menschen gleichzeitig auf der Erde leben. Und mit der Zahl der Menschen wird auch deren Klima-Einfluss steigen.

Für die Optimierung unseres Vorgehens insgesamt muss daher auch berücksichtigt werden, ob es nicht besser wäre, möglichst vielen Menschen den Zugang zu billiger, jederzeit und für jedermann verfügbarer Energie zu erleichtern. Nach Lage der Dinge kann das auf absehbare Zeit nur über fossile Energieträger erfolgen. Das erhöht natürlich zunächst die CO2-Freisetzung, reduziert sie aber über die beschriebene Wechselwirkung längerfristig. Ich kann nicht erkennen, wie diese Frage bisher bei den Klima-Vorgaben angemessen berücksichtigt worden wäre.

Zwischenergebnis

Mehr CO2 hat auch Vorteile, Klimaschutzmaßnahmen haben auch Nachteile. Wenn wir verantwortlich vorgehen wollen, müssen wir diese Aspekte gegenüber den möglichen Klimaauswirkungen von CO2 verrechnen. Solange diese Gegenrechnung nicht geschieht, wird außerdem die schon in Kapitel 1 (Klimaoptimum) beschriebene Unsicherheit bezüglich der Richtigkeit vorgesehener Maßnahmen nochmals erheblich verstärkt. Die Gegenrechnung ist daher ein dringendes Erfordernis. Soweit hierzu noch Forschungen erforderlich sind, sollten diese mit hoher Priorität vorangetrieben werden.

3 Klimamodelle

Treibhauseffekt

CO2 ist ein Treibhausgas, d. h. ein Gas, das den Strahlungshaushalt der Erde beeinflusst: Es lässt das hereinkommende Sonnenlicht weitgehend unbehindert zur Erde durch, absorbiert die in den Weltraum hinaus gehende Wärmeabstrahlung der Erde aber zu einem erheblichen Teil. Durch diese Absorption wird die Atmosphäre erwärmt. Als Folge davon sendet sie nun ihrerseits Strahlung aus. Genau genommen tut das nicht die Atmosphäre an sich, sondern nur das in ihr enthaltene CO2 (und die übrigen vorhandenen Treibhausgase), die Hauptbestandteile der Atmosphäre, Stickstoff und Sauerstoff, können Strahlung weder absorbieren noch emittieren. Diese Strahlung wird in alle Richtungen gleich ausgesendet, also je zur Hälfte nach außen in den Weltraum und zurück zur Erde. Die zur Erde zurück gehende Strahlung wird als „Gegenstrahlung“ bezeichnet (weil sie der Wärmeabstrahlung entgegen gerichtet ist). Sie führt der Erde zusätzliche Energie zu, zusätzlich zur (unveränderten!) Einstrahlung von der Sonne. Dadurch erwärmt sich die Erde über das hinaus, was nur durch die Sonneneinstrahlung alleine bewirkt wird. Das ist der „Treibhauseffekt“. Je mehr CO2 es in der Atmosphäre gibt, desto stärker ist er.

Klimasensitivität

Vorab eine Definition: Die Erwärmung der Erde (global und jahreszeitlich gemittelte, bodennahe Lufttemperatur) bei Verdoppelung der Konzentration eines Treibhausgases in der Atmosphäre wird als „Klimasensitivität“ dieses Treibhausgases bezeichnet.

Für eine trockene Atmosphäre mit nur CO2 als Treibhausgas lässt sich dessen Klimasensitivität relativ leicht berechnen: Sie beträgt ca. 1 Grad Celsius. Dieser Wert ist praktisch unumstritten. Ebenso unumstritten ist aber auch, dass dieser Wert schlichtweg zu klein ist, um in absehbarer Zeit zu schwerwiegenden Klimaauswirkungen zu führen. Zu solchen kommt man nur, wenn man erhebliche zusätzliche Verstärkungsmechanismen annimmt. Dann erwärmt sich die Erde natürlich stärker. Ist die Erwärmung stark genug, kann das klarerweise auch gravierende Folgen haben. Die „etablierte Klimawissenschaft“ macht genau das, sie geht von einer erheblichen Verstärkung aus.

Doch der Reihe nach. Real ist CO2 natürlich nicht das einzige Treibhausgas in der Luft. Und wenn mehrere Treibhausgase vorhanden sind, dann wirken alle, aber sie teilen sich bis zu einem gewissen Grad die Wirkung: Strahlung, die in einem Treibhausgas eingefangen wird, steht für ein anderes Treibhausgas nicht mehr zur Verfügung (Überlappung der Wirkungen). Die Anwesenheit anderer Treibhausgase in der Atmosphäre erhöht daher einerseits prinzipiell den Treibhauseffekt, andererseits aber reduziert sie ebenso prinzipiell die speziell dem CO2 zuzuordnende Wirkung.

Besonders wichtig ist in diesem Zusammenhang der Wasserdampf. Durch den Treibhauseffekt verdampft mehr Wasser und sammelt sich als Dampf in der Atmosphäre an. Wasserdampf ist aber selbst ein Treibhausgas, sogar ein sehr effektives. Seine erhöhte Konzentration verstärkt daher den Treibhauseffekt. Gleichzeitig wird aber die speziell vom CO2 ausgehende Treibhaus-Wirkung durch die geschilderte Überlappung reduziert. Man könnte auch sagen, dass der Wasserdampf dem CO2 einen Teil seiner Wirkung wegnimmt. Andere Treibhausgase machen das ebenso. In Summe verbleibt – andere Effekte außer Acht gelassen – zwar eine Verstärkung durch die Anwesenheit anderer Treibhausgase, wie groß die aber real ist, ist umstritten.

Doch andere Effekte gibt es. Insbesondere führt mehr Wasserdampf in der Atmosphäre prinzipiell auch zu mehr Wolkenbildung. Und diese Wolken behindern sowohl die Einstrahlung von der Sonne als auch die Wärmeabstrahlung von der Erde. Ersteres, indem sie einen Teil der Sonnenstrahlung gar nicht erst bis zur Erdoberfläche durchlassen (an bewölkten Tagen ist es kälter als bei strahlendem Schönwetter). Letzteres, indem sie einen Teil der Wärmeabstrahlung der Erde nicht in den Weltraum entkommen lassen (am Morgen nach bewölkten Nächten ist es wärmer als nach sternklaren Nächten). Welcher Effekt wie stark ist, ist Fall-spezifisch, insbesondere abhängig von der Art der Wolken und der Höhe, in der sie sich bilden. Die quantitativen Zusammenhänge kennen wir nur unzureichend. Es ist einer der großen Streitpunkte innerhalb der Klimawissenschaften, wie groß die Wasserdampf/Wolken-Rückkopplung insgesamt (einschließlich Überlappung) als globaler Mittelwert über alle Fälle tatsächlich ist. Wir wissen nicht einmal, ob diese Rückkopplung alles in allem überhaupt verstärkend wirkt (was die Mehrheit der Klimawissenschaftler annimmt), oder ob sie insgesamt sogar abschwächend wirkt (was eine Minderheit der Klimawissenschaftler annimmt). Das war vor 30 Jahren so und ist heute noch genau so, es wird nur in der Öffentlichkeit weniger häufig thematisiert.

Die Rückkopplungen über den Wasserdampf sind sicherlich die wichtigsten Rückkopplungen im Klimasystem der Erde. Es gibt aber noch zahlreiche andere mögliche Rückkopplungen. Über deren Höhe wissen wir häufig noch weniger Bescheid als beim Wasserdampf, auch bei ihnen kennen wir oft nicht einmal das Vorzeichen.

Trotz dieser Unsicherheiten geht die „etablierte Klimawissenschaft“ als Summe über alle Rückkopplungen einschließlich aller Überlappungen insgesamt von einer Verstärkung aus: Mit äußerst komplexen Modellen errechnet sie die Klimasensitivität des CO2 (also die Temperaturzunahme bei Verdoppelung der CO2-Konzentration) für die reale Erde zu „1,5 bis 4,5 Grad Celsius“ (95 % Vertrauensintervall, IPCC AR 5, 2014). Die große Bandbreite von 1,5 bis 4,5 Grad (Faktor 3!) zeigt, wie wenig wir tatsächlich vom Klima wissen. Aber auch dieses Vertrauens-Intervall wird vielfach angezweifelt. Manche Wissenschaftler gehen von höheren Werten aus, andere von niedrigeren, bis hin zu einer möglichen Abschwächung. Wenn Letzteres zutrifft, ist die Klimasensitivität des CO2 eben unter einem Grad (Wert ohne Rückkopplungen).

Das war jetzt die „etablierte Klimawissenschaft“ 2014. Sieben Jahre zuvor hatte sie die Bandbreite für die Klimasensitivität des CO2 noch mit „2 bis 4,5 Grad“ angegeben (IPCC AR 4, 2007). Die Bandbreite hat sich also in dieser Zeit nicht verkleinert, sondern sogar vergrößert, und zwar nach unten. Mehr noch, im AR 4 wurde auch ein „wahrscheinlichster Wert“ mit 3,0 ° C angegeben, im AR 5 sah sich IPCC „infolge der großen Unsicherheiten“ dazu nicht (mehr) in der Lage. Trotzdem spricht IPCC im AR 5 ausdrücklich von einer „verbesserten Beweislage“ für die Warnungen vor der anthropogenen Klimaänderung. Das mag verstehen wer will, ich kann es nicht.

Weil ein „wahrscheinlichster Wert“ nicht mehr angegeben wird, wird in öffentlichen Aussagen zum Klimaproblem umso häufiger vom oberen Ende des Intervalls ausgegangen. Die Gefahren möglichst groß darzustellen, scheint zum Geschäft zu gehören.

Beobachtungen

Vorab: Über die ganze Erde und über das Jahr gemittelte Temperaturen können wir nicht direkt messen, sondern nur aus verschiedenen Quellen rechnerisch ermitteln. Im Wesentlichen gibt es 3 solcher Quellen:

- Landgestützte Thermometer: Gibt es sehr viele, sie messen an diskreten Punkten nahe der Erdoberfläche; diese Messungen reichen am weitesten zurück, doch haben sich die Randbedingungen an den Messorten im Laufe der Zeit häufig verändert (Verbauung, Standortwechsel, Gerätetausch, …) und die Mittelwertbildung (zeitlich wie räumlich) ist bis zu einem gewissen Grad willkürlich.

- Thermometer in Wetterballonen: Sind viel seltener, messen aber auch in unterschiedlicher Höhe (wichtig, weil der Treibhauseffekt die gesamte Troposphäre erwärmt).

- Satelliten: Gibt es erst seit 1979. Sie messen quasi flächendeckend und quasi kontinuierlich, aber verfahrensbedingt Mittelwerte über einige km Höhe in der Atmosphäre.

Bei allen 3 Quellen gibt es im Detail Diskussionen (auch sehr heftige Diskussionen!), wie aus den Basismesswerten die globalen Jahresmittelwerte und deren zeitliche Veränderung errechnet werden. Die Ergebnisse stimmen aber ausreichend überein, um die Klimaentwicklung wenigstens in groben Zügen quantitativ beschreiben zu können.

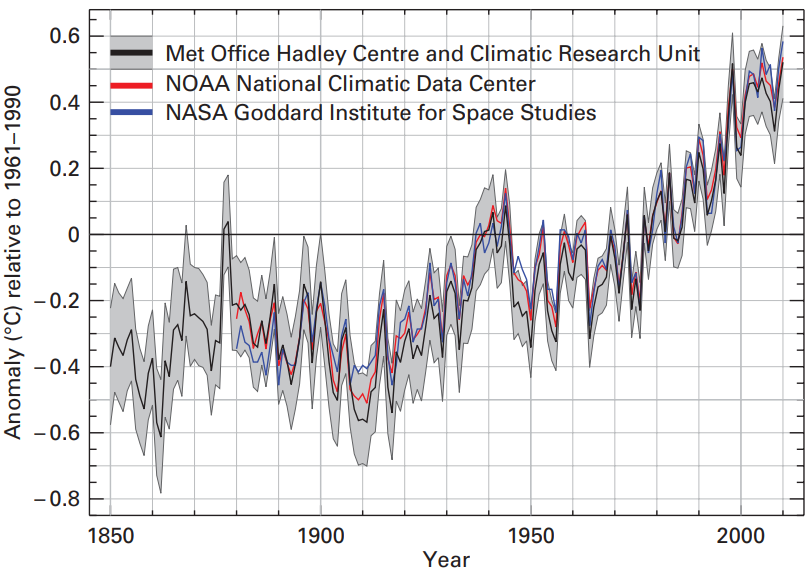

Abb. 4 zeigt das für die Jahre 1850 bis 2010. In dieser Zeit ist es, übereinstimmend nach allen Quellen, eindeutig wärmer geworden. Aber nicht kontinuierlich, sondern in 3 klar voneinander getrennten Schüben von jeweils grob etwa 30 Jahren Dauer (ca. 1860 bis 1880, ca. 1910 bis 1945 und ca. 1975 bis 2000). Die Erwärmungsschübe unterscheiden sich auch in ihrer Steilheit nicht signifikant. Dazwischen liegen jeweils ungefähr gleich lange Zeiträume mit stagnierender bis leicht abnehmender Temperatur (ca. 1880 bis 1910 und ca. 1945 bis 1975).

Abb. 4: Verlauf der global und jahreszeitlich gemittelten, bodennahen Lufttemperatur 1850 bis 2010. Quelle: WMO.

Um das Bild zu vervollständigen sei noch darauf hingewiesen, dass die Erwärmung genau genommen schon 200 Jahre früher begonnen hat, zum Ende der Kleinen Eiszeit um 1650 herum. Damit passt die Entwicklung insgesamt gut zu den in Abb. 1 gezeigten 1000-jährigen zyklischen Schwankungen der letzten 4000 Jahre. Aber in Abb. 4 erkennen wir auch, dass die allmähliche Erwärmung zur jetzigen Warmzeit hin nicht nur von kurzzeitigen Schwankungen von Jahr zu Jahr, sondern auch von einem etwa 30-jährigen Auf und Ab der Temperaturen überlagert worden ist. Das passt gut zu Zyklen mit ähnlichen Perioden, wie sie sowohl von der Sonne als auch bei Meeresströmungen bekannt sind. Auf Einzelheiten hierzu möchte ich aus Platzgründen hier nicht näher eingehen, die Tatsache dieser Überlagerungen mit mehrdekadischen Zyklen scheint mir jedoch wichtig zu sein, wichtig für die Frage, aus welchen Zeitintervallen man für welche Zeitintervalle Schlussfolgerungen ziehen darf.

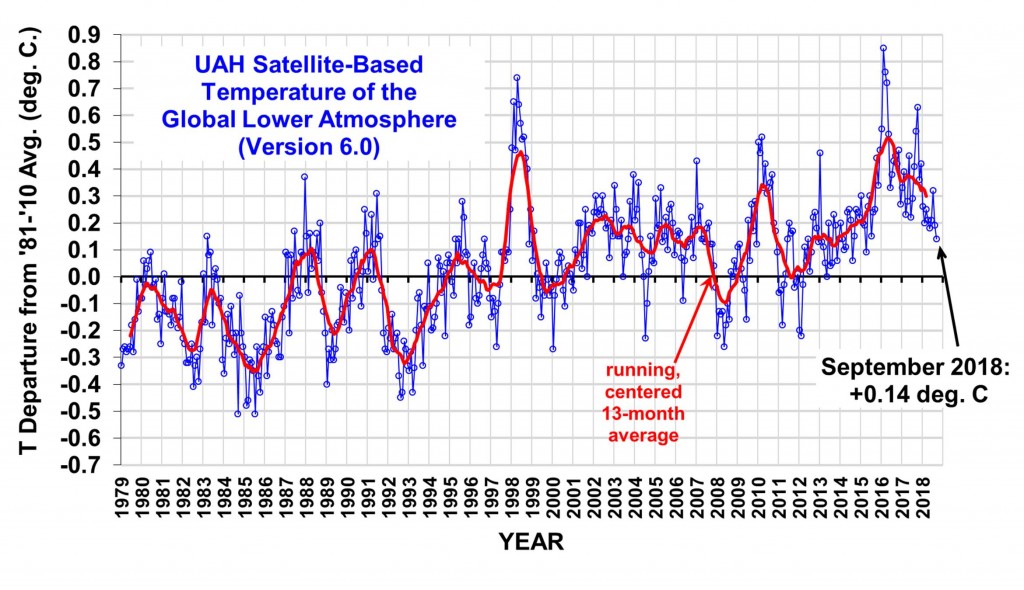

Im 21. Jahrhundert ist der Temperaturverlauf dann kontroverser. Die verschiedenen Auswertungen weisen da stärkere Unterschiede auf. Aber einen deutlich flacheren Anstieg als in den Jahrzehnten davor zeigen sie alle. Abb. 5 gibt als Beispiel Satellitenmessungen der globalen unteren Atmosphäre von 1979 bis September 2018 wieder. Man sieht vor allem einmal erhebliche kurzfristige Schwankungen. Diese sind vornehmlich auf El Nino- und La Nina-Ereignisse zurück zu führen. Das sind reversible Umlagerungen von Meeresströmungen im pazifischen Raum, die unregelmäßig alle paar Jahre mit unterschiedlicher Intensität auftreten. Global wirken El Nino-Ereignisse prinzipiell erwärmend, La Nina-Ereignisse prinzipiell abkühlend. Beide Ereignisse sind immer „Wetter“ und niemals „Klima“.

„Klima“ sind nur die längerfristigen Änderungen. Da kann man in Abb. 5 bis etwa 1998 einen deutlichen Anstieg der Temperatur und danach eine zunächst eher abnehmende Tendenz erkennen. Das Erstere entspricht der (generell unstrittigen) Erwärmung im letzten Quartal des 20. Jahrhunderts, das Letztere der (in ihrem Ausmaß umstrittenen) Verflachung im 21. Jahrhundert. Erst 2016 ist die Temperatur dann wieder stark angestiegen (Anmerkung: In manchen Datensätzen ist die Temperatur auch schon 2015 deutlich angestiegen, das ist ein Beispiel der schon genannten Unterschiede). 2016 war das wärmste Jahr überhaupt. 2017 war wieder etwas kälter und bis zum September 2018 ist die Temperatur wieder auf das Ausgangsniveau vor dem Rekordwert von 2016 gefallen. Global war der September 2018 sogar der kälteste September seit 10 Jahren. Der besonders hohe Wert 2016 lässt sich mit einem besonders starken El Nino-Ereignis in diesem Jahr erklären, analog wie auch der sehr hohe Wert 1998. Ob die Temperatur in der nächsten Zeit weiter fallen oder wieder ansteigen wird, wird erst die Zukunft zeigen.

Abb. 5: Temperaturentwicklung 1979 bis September 2018. Auswertung von Satellitenmessungen an der University of Alabama, Huntersville, USA, durch Roy Spencer.

Vergleich Temperatur und CO2

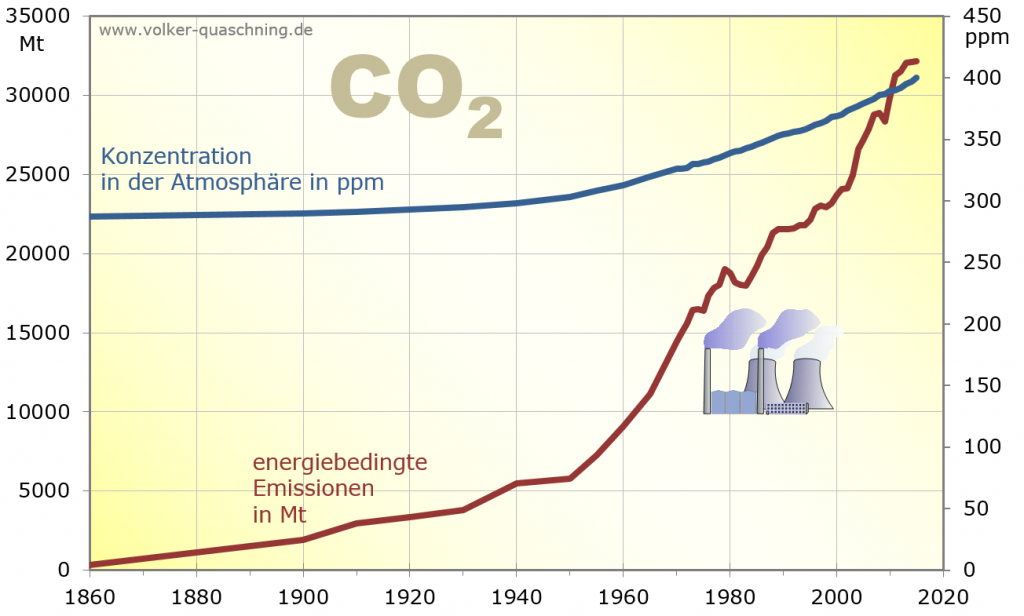

Den Temperaturverläufen in den Abb. 4 und 5 ist in Abb. 6 der Verlauf der durch die Verbrennung von Kohle, Öl und Gas bewirkten CO2-Freisetzungen gegenübergestellt. Mit angegeben ist auch die Entwicklung der atmosphärischen CO2-Konzentration. Die (anthropogenen) CO2-Freisetzungen sind von minimalen Werten ausgehend zunächst langsam und nach dem Zweiten Weltkrieg dann ganz gewaltig angestiegen (von 1950 bis heute fast auf das Zehnfache!). Als Konsequenz dieser Freisetzungen ist die CO2-Konzentration mit etwa ähnlichem Verlauf angestiegen, allerdings nicht von quasi Null aus, sondern vom vorindustriellen Ausgangswert von ca. 280 ppm (parts per million, Millionstel Volumenanteile) ausgehend auf heute gut 400 ppm. Das ist immerhin eine Zunahme um fast 50 %! Außerdem steigt die Konzentration derzeit jährlich um ca. 2 ppm weiter. Wenn das so weiter geht, wird sie sich bis Ende des Jahrhunderts in etwa verdoppelt haben. Ob das so kommt, wissen wir nicht, da wir erstens die zukünftigen Emissionen nicht genau kennen und zweitens nicht wissen, wie sehr die Senken für das atmosphärische CO2 mit dessen Konzentration zunehmen.

Ab. 6: Verlauf der atmosphärischen CO2-Konzentration und der energiebedingten CO2-Freisetzungen seit 1860. Quelle: Prof. Volker Quaschning, HTW Berlin.

Vergleicht man die gemessenen Kurven von Temperatur und CO2, so passen sie nur in einem einzigen Zeitraum gut zusammen: Dem letzten Quartal im 20. Jahrhundert. Sonst ist von Gleichlauf nicht viel zu merken. Im Einzelnen:

- In der gesamten Nacheiszeit bis zur industriellen Revolution gab es erhebliche Temperaturschwankungen (Abb. 1). Die CO2-Konzentration ist in dieser Zeit aber auffallend konstant bei ca. 280 ppm geblieben (ohne Abb.). Die Ursache der Temperaturschwankungen muss daher eine andere gewesen sein.

- In der Zeit ca. 1850 bis 1950 waren die CO2-Freisetzungen noch sehr klein, so klein, dass sie kaum einen wesentlichen Einfluss auf das Klima gehabt haben können (schon gar nicht, wenn die viel höheren Freisetzungen nach 2000 zu keiner hohen Erwärmung geführt haben). Die beiden Erwärmungsschübe ca. 1860 bis 1880 und ca. 1910 bis 1945 müssen daher überwiegend andere Ursachen gehabt haben.

- Im letzten Quartal des 20. Jahrhunderts gab es hohe CO2-Freisetzungen und parallel dazu eine starke Erwärmung. Hier kommt CO2 als Hauptverursacher in Frage, muss es aber nicht gewesen sein.

- Im 21. Jahrhundert schließlich waren die CO2-Freisetzungen auf Rekordhöhe, die Temperatur ist aber, wenn überhaupt, kaum noch gestiegen. Hier muss es andere Einflüsse gegeben haben, die den des CO2 in etwa aufgewogen haben.

Summarisch kann man feststellen, dass andere Ursachen auf jeden Fall vor 1975 und nach 2000 erheblichen Einfluss auf das Klima gehabt haben, manchmal erwärmend, manchmal abkühlend. Es liegt nahe, dass diese Einflüsse auch zwischen 1975 und 2000 mit am Wirken waren und einen Teil zur Erwärmung in diesem Zeitraum beigetragen haben. Eine nachvollziehbare Erklärung dafür, warum das anders gewesen sein soll, warum also die „anderen Ursachen“ von 1975 bis 2000 abgeschaltet gewesen sein sollen und in diesem Zeitraum nur das CO2 gewirkt haben sollte, konnte ich nirgends finden. Natürlich schließt sich sofort die Frage an: Wie wirken diese „anderen Ursachen“ in der Zukunft? In den Computermodellen wird ihnen kein großer Einfluss zugebilligt. Mit welcher Berechtigung?

Zusammenfassend lassen sich m. E. zwei Aussagen machen:

- Die Beobachtungen zeigen insgesamt keine gute Übereinstimmung der Kurven für CO2-Konzentration und Temperatur. Sie lassen daher eher eine nur geringe Klimasensitivität des CO2 vermuten. Eine hohe Klimasensitivität ergibt sich nur aus (sehr komplexen) Rechnungen.

- Von der Gesamterwärmung seit 1850 um ca. 1 °C ist höchstwahrscheinlich nur ein Teil auf CO2 zurück zu führen, für den vermutlich sogar größeren Teil kommen realistisch betrachtet nur andere (natürliche) Ursachen in Frage.

Anmerkung: Im neuesten IPCC-Bericht (SR1.5 „1,5 ° globale Erwärmung“, Oktober 2018) wird die gesamte Erwärmung seit 1850 um ca. 1 Grad ohne nähere Begründung einfach als „vom Menschen verursacht“ ausgewiesen. Für mich bestätigt das den oft erhobenen Vorwurf, IPCC gehe es weniger um ausgewogene wissenschaftliche Darstellung, als vor allem um das Durchsetzen gewünschter weltweiter Entwicklungen.

Nagelprobe

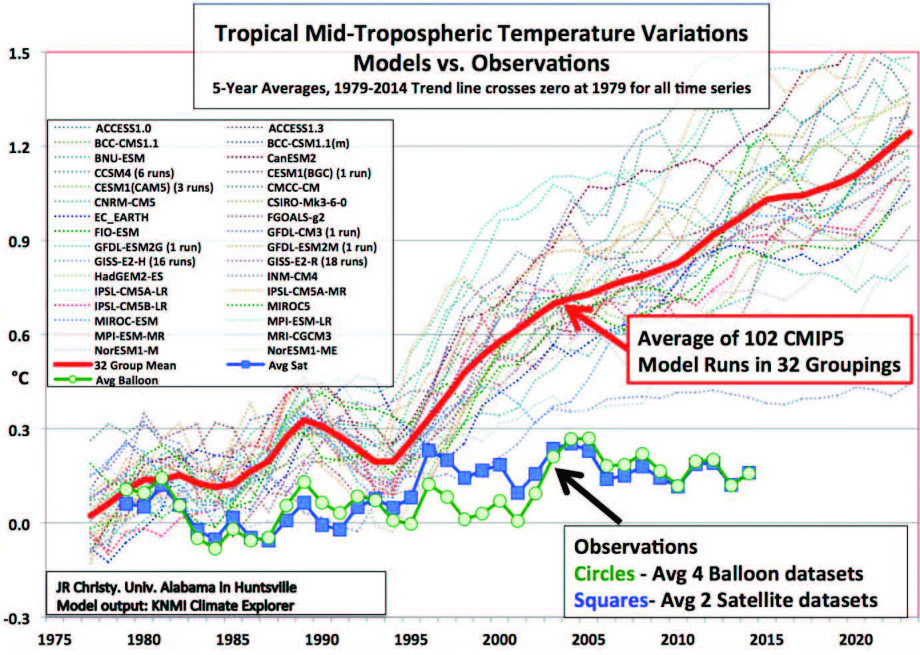

Computerrechnungen weisen bei fortgesetzter CO2-Freisetzung gravierende Klimafolgen aus. Beobachtungen stützen das nicht, wie gerade gezeigt. Was sonst noch kann die Rechnungen stützen? Dazu muss man zunächst sagen, dass das Klima prinzipiell ein chaotisches System ist, das nur eingeschränkt berechnet werden kann. Die äußerst komplexen physikalisch/mathematischen Modelle hierfür enthalten viele Annahmen und Näherungen, die nicht notwendigerweise stimmen müssen. Die Fachwelt ist sich einig: Das beste Nachweisinstrument für die Qualität (man spricht von „Validität“) solch komplexer Computermodelle ist die Vorausrechnung geeigneter Szenarien („Klimaprojektionen“) mit nachträglicher Überprüfung der Ergebnisse anhand der tatsächlich eingetreten Entwicklungen.

Das hat man natürlich gemacht, aber das Ergebnis ist ernüchternd: Keine der Ende des 20. Jahrhunderts durchgerechneten Klimaprojektionen hat die ab ca. 1998 eingetretene Abflachung der Erwärmung (möglicherweise sogar Stopp der Erwärmung, siehe Abb. 5) bei nochmals erhöhter CO2-Freisetzung vorausgesagt. „Die Nagelprobe nicht bestanden“, scheint mir die Situation richtig zu beschreiben.

Natürlich sind die Modelle zwischenzeitlich weiterentwickelt worden. In einigen Jahren bis Jahrzehnten werden wir wissen, wie gut die heutigen Vorausrechnungen mit der real eintretenden Entwicklung übereinstimmen. Bis dahin müssen wir uns mit einem Vergleich der Modellrechnungen mit der historischen Klimaentwicklung begnügen.

In Abb. 7 ist das Ergebnis wiedergegeben: Es ist nach wie vor ernüchternd. Da die Messwerte von 2 völlig unabhängigen Systemen (Ballonen und Satelliten) sehr gut übereinstimmen, ist der Grund für die Abweichungen wohl eindeutig in den Modellen zu suchen. Diese sind offensichtlich weiterhin nicht vertrauenswürdig. Vermutlich, weil sie darauf ausgerichtet sind, die Entwicklung im letzten Quartal des 20. Jahrhunderts im Wesentlichen durch CO2 zu erklären. Als Folge davon berechnen sie eine viel zu hohe Erwärmung im 21. Jahrhundert.

Abb. 7: Vergleich der Rechenergebnisse von Klimamodellen mit Messwerten, Temperatur-Mittelwerte über die tropische Troposphäre (0 bis ca. 15 km Höhe). Zur unmittelbaren Vergleichbarkeit wurden alle Kurven an den gleichen Ausgangspunkt angepasst (linearer Trend schneidet die Nulllinie im Jahr 1979, dem Beginn der Satellitenmessungen). Quelle: Testimony of John R. Christy, U. S. House Committee on Science, Space & Technology,2 Feb 2016.

Aber auch die Temperaturentwicklung vor der Periode 1975 bis 2000 können die Modelle nicht richtig nachvollziehen: Warm- und Kaltphasen im Holozän, Mittelalterliches Klimaoptimum, Kleine Eiszeit, Erwärmungsschübe ca. 1860 bis 1880 und 1910 bis 1945, Abkühlung dazwischen und danach werden nur sehr unvollkommen von den Modellen nachempfunden. Diese Klimaentwicklungen folgten eben nicht dem CO2, sondern vorwiegend natürlichen Einflüssen, die in den Modellen ganz offensichtlich zu kurz kommen. Nur zur Erwärmung ca. 1975 bis 2000 passen die Modelle gut. Diese Erwärmung ausschließlich dem CO2 zuzuordnen und den Beitrag anderer Ursachen (insbesondere der zyklischen Prozesse, siehe oben) praktisch zu ignorieren, scheint mir ein grundlegender Fehler der Programme zu sein.

Wahrscheinlich würden in jedem anderen Wissenschaftsfeld Rechenmodelle mit so schlechten Ergebnissen als „noch nicht ausreichend validiert“ zurückgewiesen werden. Offensichtlich nicht so in der Klimawissenschaft. Hier werden diese Rechenmodelle, die die Vergangenheit nicht richtig widergeben können, für Vorausrechnungen bis zum Ende des Jahrhunderts verwendet! Aus den Ergebnissen werden dann Forderungen abgeleitet, die ganz gravierende Auswirkungen auf Wirtschaft und Gesellschaft haben. Und diejenigen, die das tun, wundern sich, dass irgendjemand Zweifel an der Schlüssigkeit dieser Forderungen haben kann!

Aerosole

Unabhängig vom detaillierten Kurvenverlauf (siehe gerade) sollte die hohe Klimawirksamkeit der Treibhausgase, wie sie in den Modellen angenommen wird, insgesamt eine entsprechend hohe Erwärmung seit Beginn der industriellen Revolution zur Folge haben. Real ist es in dieser Zeit aber nur ungefähr halb so warm geworden. Um dem gerecht zu werden, wird in den Modellen neben der (starken) Erwärmung über Treibhausgase auch ein kühlender Einfluss angenommen, der die Erwärmung bremst. Erreicht wird das über Aerosole. Das sind feine Staubteilchen oder Flüssigkeitstropfen, die, wenn sie in der Atmosphäre sind, überwiegend die Sonneneinstrahlung behindern und dadurch kühlend wirken. In die Atmosphäre kommen sie durch direkte Freisetzung oder sie bilden sich dort aus anderen Freisetzungen, z. B. aus SO2 in den Abgasen von Kraftwerken mit schwefelhaltigem Brennstoff. Neben der anthropogenen Freisetzung gibt es auch natürliche Freisetzungen, z. B. durch Vulkane.

Mit einem Kühleffekt der aus SO2-Freisetzungen entstehenden Aerosole erklärt die „etablierte Klimawissenschaft“ die beobachtete Temperaturentwicklung wie folgt: Nach dem zweiten Weltkrieg wurden im Rahmen des wirtschaftlichen Wiederaufbaus große Mengen schwefelhaltiger Brennstoffe zur Strom- und Wärmeerzeugung sowie im Verkehrswesen eingesetzt. In deren Abgasen war entsprechend viel SO2 enthalten. Daraus bildeten sich dann in der Atmosphäre Aerosole. Diese haben den erwärmenden Einfluss des CO2 massiv reduziert, zum Teil sogar überkompensiert. Daher die rücklaufenden Temperaturen ca. 1945 bis 1975 und insgesamt seit 1850 nur etwa halb so viel Erwärmung als durch das CO2 alleine. Ab etwa 1970 wurden dann Brennstoffe entschwefelt und Entschwefelungsanlagen für die Kraftwerke gebaut. Dadurch gingen die Aerosole und deren kühlende Wirkung zurück und es wurde wieder wärmer. Von ca. 1975 bis 2000 war die Temperaturentwicklung weitgehend allein vom CO2 bestimmt. Deshalb, so wird so wird aus all dem gefolgert, wäre es zulässig, in den Programmen CO2 als jetzigen und zukünftigen Haupttreiber anzunehmen.

Das alles klingt auf den ersten Anschein hin gut, aber wenn man genauer hinsieht, ergeben sich Probleme: Insbesondere hat die Umsetzung der Entschwefelungsmaßnahmen Zeit gebraucht. Real sind die SO2-Freisetzungen daher zunächst noch weiter angestiegen, ein Rückgang ist erst seit ca. 1990 zu beobachten. Auch die Aerosole können daher erst nach 1990 zurück gegangen sein. Das Klima hat sich aber bereits ab ca. 1975 erwärmt. Es müsste also die Auswirkungen der SO2-Reduzierungen vorweg genommen haben!

Aber auch die Abflachung der Temperaturkurve im 21. Jahrhundert wird manchmal nach dem gleichen Muster erklärt: Sie sei dem wirtschaftlichen Aufschwung in China mit wieder vermehrtem Einsatz von schwefelhaltigen Brennstoffen geschuldet. Als dann die Luft in Chinas Städten zu schlecht wurde und endlich auch dort Umweltschutzmaßnahmen eingeleitet wurden, hätte das zum neuerlichen Temperaturanstieg ab 2015 geführt. Das scheint mir eine Erklärung „nach Wunsch“ zu sein. Ein so promptes Reagieren des weltweiten Klimas auf Änderungen in einem einzelnen Land kann ich mir nur schwer vorstellen. Außerdem sind die Temperaturen seit 2016 wieder deutlich gesunken (Abb. 6), ohne dass sich in China viel geändert hätte.

Trotz dieser Widersprüchlichkeiten wird in der „etablierten Klimawissenschaft“ am starken Korrektiv der CO2-Wirksamkeit durch Aerosole festgehalten. Dabei wird auch ausgenutzt, dass die (globale) Konzentration der Aerosole infolge ihrer kurzen Verweilzeit in der Atmosphäre nur schwer zu messen ist. Sie muss daher weitgehend angenommen werden. Und das wird anscheinend gerade so gemacht, dass die Modelle das gewünschte Ergebnis liefern. Sehr vertrauenserweckend wirkt das auf mich nicht.

Noch wichtiger erscheint mir aber, dass sich Hinweise auf eine real viel kleinere Aerosolwirksamkeit als in den Modellen angenommen mehren. Gewonnen werden diese Erkenntnisse hauptsächlich aus Untersuchungen zur Klimawirksamkeit von Vulkanausbrüchen. Da werden Aerosole ausgestoßen und die Folgen können analysiert werden. Die scheinen eindeutig kleiner zu sein, und zwar merklich kleiner, als in den Modellen angenommen.

Wenn aber die Klimawirksamkeit der Aerosole reduziert werden muss, dann muss auch die Klimawirksamkeit der Treibhausgase reduziert werden. Nur so lassen sich die Rechenergebnisse wenigstens einigermaßen mit den Beobachtungen in Einklang bringen. Bricht das Aerosol-Argument weg, brechen vermutlich auch die Katastrophen-Prophezeiungen weg! Die Aerosol-Wirksamkeit könnte zu einer entscheidenden Frage für die Klima-Problematik werden. Hier sind weitere Untersuchungen dringend erforderlich.

Hot Spot

Insbesondere in den Tropen verdampft infolge der hohen Temperaturen viel Wasser und sammelt sich als Dampf in der Troposphäre an. Wasserdampf ist aber, wie gesagt, ein Treibhausgas. Mit der starken Treibhausgas-Wirksamkeit der Modelle errechnet man daher für den oberen Bereich der äquatornahen Troposphäre eine besonders hohe Erwärmung. Von den Fachleuten wird die als „hot spot“ bezeichnet. Bei Messungen (mit Ballonen und von Satelliten aus) findet man diesen hot spot aber nicht. Wieder muss man die Treibhausgas-Wirksamkeit in den Modellen reduzieren, dann verschwindet der hot spot in den Rechnungen und diese stimmen besser mit den Beobachtungen überein. Aber dann erhält man auch keine bedrohliche Erwärmung durch die Treibhausgase!

Die Indizien für eine Überschätzung der Klimasensitivität der Treibhausgase in den Modellen sind meines Erachtens erheblich. Weitere Forschungsanstrengungen zur Abklärung des realen Sachverhaltes sind dringend notwendig.

Latentwärmeabfuhr

Wie anfangs von Kap. 3 dargelegt, ist der (erwärmende!) Treibhauseffekt eine Folge der Strahlungseigenschaften des CO2 (und der anderen Treibhausgase). Diese Eigenschaften bewirken aber noch einen zweiten Effekt: Sie ermöglichen den Transport von Wärme, die als latente Wärme von der Erdoberfläche in die Atmosphäre eingebracht wird, weiter in den Weltraum. Latente Wärme gelangt vor allem durch Verdunstung von Wasser in die Atmosphäre. Gäbe es dort keine Treibhausgase, könnte diese Wärme nur über materiegebundene Prozesse (z. B. Regen) wieder von der Atmosphäre abgegeben werden, da Stickstoff und Sauerstoff nicht strahlen. Die materiegebundenen Prozesse gehen aber (von minimalen Spurenmengen abgesehen) nie in den Weltraum, sondern immer nur zurück zur Erde, eben wie der Regen. Ohne Treibhausgase würde sich daher ein Gleichgewicht einstellen, bei dem laufend so viel Wärme materiegebunden zur Erde zurück geht, wie als Latentwärme in die Atmosphäre eingebracht wird. Mit Treibhausgasen geht ein Teil dieser Wärme nicht zurück zur Erde, sondern wird aus der Atmosphäre in den Weltraum abgestrahlt. Das ist ein zweiter Wärmeabfuhrpfad von der Erdoberfläche in den Weltraum, zusätzlich zu dem über die Abstrahlung von der Erdoberfläche.

Dieser (abkühlende!) Effekt ist eine unmittelbare Folge der Strahlungseigenschaften der Treibhausgase und damit ein unvermeidbarer Begleiter des (erwärmenden!) Treibhauseffektes. In den Klimamodellen ist er prinzipiell enthalten, die Frage ist aber, ob ausreichend. Dies umso mehr, als das Verhältnis der beiden Effekte mit zunehmender Treibhausgaskonzentration immer mehr zugunsten der Latentwärmeabfuhr verschoben wird, da die Absorption von Strahlung in den Treibhausgasen prinzipiell einer Sättigung zustrebt. Auch hier scheinen weitere Abklärungen dringend erforderlich zu sein.

Andere Ursachen

Die Klimamodelle sind gezielt zum Nachweis des menschengemachten Einflusses auf das Klima entwickelt worden. Vielleicht kommen sie (und die sie betreibenden Wissenschaftler) auch gerade deswegen zum Ergebnis, dass der (anthropogene) Treibhauseffekt Hauptverursacher der Erwärmung der letzten 150 Jahre ist. Nur so, so wird immer wieder gesagt, lässt sich diese Erwärmung ausreichend erklären. Im Umkehrschluss dazu wird ein großer Einfluss anderer Ursachen ausgeschlossen.

Aber diese Argumentation hat m. E. drei prinzipielle Schwächen:

- Erstens lässt sich damit vielleicht die Erwärmung von ca. 1975 bis 2000 ausreichend erklären, nicht aber der Temperaturverlauf davor und danach, der ist gerade nicht eindeutig dominierend vom CO2 bestimmt, siehe oben.

- Zweitens kann man auf diese Art nur solche Dinge ausschließen, die man mit untersucht hat. Nicht berücksichtigte oder gar unbekannte Effekte (niemand kennt alles!) können damit gerade nicht ausgeschlossen werden.

- Und drittens ist der Ausschluss auch dann unberechtigt, wenn ein bestimmter Effekt fehlerhaft oder unvollständig berücksichtigt worden ist.

Alle drei Einschränkungen sind m. E. logisch zwingend. Den letzten Punkt (fehlerhafte oder unvollständige Berücksichtigung) möchte ich anhand des Sonneneinflusses auf das Klima näher erläutern, für andere mögliche Einflüsse (z. B. zyklische Ozeanströmungen, etc.) gilt Analoges:

Die Sonne ist zweifellos der wichtigste Klima-Faktor auf der Erde. Bei näherem Hinsehen strahlt sie nicht immer makellos hell, sondern zeigt oft auch dunkle Flecken, die sogenannten „Sonnenflecken“. Diese sind auf gewaltige energetische Prozesse in der Sonne zurück zu führen. Daher strahlt die Sonne auch etwas stärker, wenn sie viele Sonnenflecken hat. Bekanntlich schwankt die Zahl der Sonnenflecken in etwa 11-jährigem Rhythmus, überlagert durch längerfristige Zyklen oder Schwankungen. Bekannt sind vor allem das Maunder-Minimum 1645-1715 und das Dalton-Minimum 1790-1830 mit nahezu keinen Sonnenflecken. Auf der Erde war es in diesen Zeiten ungewöhnlich kalt, während es im 20. Jahrhundert bei sehr vielen Sonnenflecken deutlich wärmer war. In meinen Augen begründet das einen Anfangsverdacht für einen wichtigen Einfluss der Sonnenflecken auf unser Klima.

Aber man muss quantifizieren. Um wie viel stärker die Sonne in einem Sonnenfleckenmaximum strahlt, kann man über Satelliten gut messen: Die „total solar irradiance“ (TSI) erhöht sich um ca. 0,1 Prozent. Das ist sehr wenig und wenn man es mit anderen Klimaeinflüssen vergleicht (oder in die Rechenmodelle eingibt), ergibt sich tatsächlich nur eine verschwindend kleine Wirkung. Also doch kein (nennenswerter) Einfluss?

Doch auch der Treibhausgas-Einfluss ist ja verhältnismäßig klein und erreicht, wie dargelegt, seinen möglicherweise bestimmenden Einfluss auf das Klima nur durch mögliche Verstärkungsmechanismen. Kann es solche Verstärkungsmechanismen nicht auch für die Sonnenflecken geben? Ja, kann es, sie werden nur in den Rechenmodellen normalerweise nicht berücksichtigt. Als Begründung wird meist angegeben, dass da noch zu viele Unsicherheiten vorhanden wären. Wo ist da der Unterschied zur Wasserdampfverstärkung?

Außerhalb der Rechenmodelle werden in der Fachwelt auch mehrere solcher Mechanismen diskutiert. Z. B. ändert sich der UV-Anteil an der Sonnenstrahlung mit der Zahl der Sonnenflecken sehr viel stärker als die Gesamtstrahlung (TSI), in Teilbereichen sogar um bis zu 70 Prozent! Diese UV-Strahlung beeinflusst die Temperatur der oberen Atmosphärenschichten der Erde ganz erheblich. Das kann alleine oder im Zusammenwirken mit anderen Effekten erhebliche Klimaauswirkungen haben.

Ein anderer möglicher Verstärkungsmechanismus geht über die galaktische kosmische Strahlung. Das ist ein ständiger Strom hochenergetischer Teilchen, die aus den Tiefen des Weltraumes zur Erde kommen. In der Atmosphäre trägt die kosmische Strahlung – so die Erklärung – durch die Bildung von Kondensationskeimen zur Wolkenbildung bei und wirkt dadurch abkühlend (Zurückwerfen der Sonnenstrahlung). Entscheidend ist nun, dass die Menge der kosmischen Strahlen, die die Erde treffen, von der Stärke des Magnetfeldes der Sonne abhängt. Dieses Magnetfeld lenkt einen erheblichen Teil der kosmischen Strahlung großflächig um das Sonnensystem (und damit auch um die Erde) herum, je stärker es ist, umso mehr. Und stärker ist das Magnetfeld, sogar um bis zu 10 Prozent stärker, wenn die Sonne stärker aktiv ist, also wenn sie viele Sonnenflecken hat. So schließt sich der Kreis: Viele Sonnenflecken heißen starkes Magnetfeld, wenig kosmische Strahlung, wenig Wolken, warm. Umgekehrt heißen wenige Sonnenflecken schwaches Magnetfeld, viel kosmische Strahlung, viele Wolken, kalt. Die Sonnenflecken sind dabei nicht der eigentliche Treiber für die Klimaänderungen, sondern das Magnetfeld, aber die Sonnenflecken sind die für uns sichtbare Begleiterscheinung der Änderungen des Magnetfeldes.

Im Prinzip sind alle Teilschritte dieses Prozesses physikalisch verstanden und auch durch Beobachtungen belegt, aber seine Größe insgesamt ist umstritten. Da sind noch weitere Forschungsanstrengungen erforderlich. Vor allem aber ist es erforderlich, ihn als potentielle Möglichkeit in die Überlegungen mit einzubeziehen, auch in den Rechenmodellen. Die angegebene Ausschluss-Argumentation kann nicht aufrecht erhalten werden!

Bewertung der Situation

Dass das Klima sich in den letzten 100 Jahren erwärmt hat, ist unstrittig (eigentlich sogar in den letzten 400 Jahren). Streit gibt es jedoch über Ursachen dieser Erwärmung. Und natürlich über die Frage, wie es weitergehen wird. Klimamodelle gehen von einer hohen Wirksamkeit der Treibhausgase aus und berechnen damit bis Ende des Jahrhunderts erhebliche Konsequenzen, wenn die anthropogenen CO2-Freisetzungen nicht drastisch reduziert werden. Beobachtungen widersprechen in vielen Bereichen den Modellen. Sie zeigen eher eine nur geringe Klimasensitivität des CO2 und einen erheblichen Beitrag anderer Verursacher zur Erwärmung. Die Sorge vor katastrophalen Entwicklungen lässt sich mit ihnen jedenfalls nicht begründen. Die Situation ist völlig unbefriedigend, aber solange die Diskrepanz zwischen Rechnung und Beobachtung nicht offen zugegeben wird, wird es schwer sein, diese Diskrepanz zu schließen und eine Verbesserung herbei zu führen.

4 Gegenmaßnahmen

Ungeachtet aller offenen Fragen wurden in vielen Ländern konkrete Maßnahmen zum Klimaschutz beschlossen. In Deutschland ist das insbesondere die Energiewende. Mit ihr als zentralem Instrument sollen nicht nur die Verpflichtungen aus dem Pariser Klima-Abkommen erfüllt werden, sondern auch die darüber hinausgehende Selbstverpflichtung Deutschlands. Diese sieht bis zum Jahr 2020 eine Reduzierung der CO2-Freisetzungen um 40 % gegenüber dem Jahr 1990 vor, bis 2030 um 55 % und bis 2050 um 80-95 %.

Nachfolgend will ich der Frage nachgehen, ob so starke Reduzierungen überhaupt möglich sind, unabhängig von den bisher geäußerten Zweifeln an ihrer Notwendigkeit. Die Überlegungen gelten für andere Länder und deren Verpflichtungen ähnlich.

Das EU-Zertifikatesystem

Die EU als großer Wirtschaftsraum hat beschlossen, in ihrem Bereich den Klimaschutz über ein System handelbarer Zertifikate voranzubringen. Wer CO2 freisetzen will, benötigt hierzu ausreichend viele Zertifikate. Hat er zu wenige, muss er sich am Markt zusätzliche kaufen, hat er zu viele, kann er sie am Markt verkaufen. Die Zertifikate werden von der EU nach einem bestimmten Schlüssel an die Mitgliedsländer vergeben. Ihre (jährlich abnehmende) Gesamtzahl legt eine (sinkende) Obergrenze für die CO2-Freisetzungen in der Union fest, mehr Freisetzungen gibt es nicht. Das ist der Klimaschutz der EU. Der Handel mit den Zertifikaten selbst hat keine klimaschützende Funktion. Mit ihm soll nur der wirtschaftlichste Weg zum Einhalten der Obergrenze ausgewählt werden.

Natürlich gibt es durch den eingeschränkten Geltungsbereich der EU-Regelung Schlupflöcher in Form des Ausweichens auf Drittländer. Wenn man davon aber einmal absieht, ist das Zertifikatesystem ein zuverlässiges System (feste Obergrenze!) und durch das Abstützen auf Marktmechanismen auch ein wirtschaftlich relativ effektives System. Es hat aber auch seine Nebenwirkungen: Zusätzliche Reduktions-Maßnahmen in den einzelnen Ländern (oder auch in den einzelnen Betrieben) sind unvermeidbar wirkungslos: Sofern sie tatsächlich zunächst Erfolg haben, werden mit der reduzierten CO2-Freisetzung auch entsprechend viele Zertifikate frei. Diese kommen auf den Markt (sie haben ja einen Wert!), werden dort verkauft und der Käufer setzt dann exakt die gleiche Menge CO2 frei (dafür hat er die Zertifikate ja gekauft), nur nun eben an anderer Stelle. Dem Klima ist diese örtliche Verlagerung egal.

Das gilt auch für die Energiewende: Jede t CO2, die Deutschland ggf. infolge dieser Energiewende weniger frei setzt, wird von einem anderen Land (in dem der Käufer der Zertifikate sitzt) freigesetzt. Für das Klima ist das ein Nullsummenspiel. Die Energiewende kostet viel Geld (siehe weiter unten), kann dem Klima aber nicht helfen. Solange es das EU-Zertifikatesystem gibt, führen Maßnahmen wie die Energiewende nur zu einer örtlichen Verlagerung der Freisetzungen, nicht aber zu einer Reduzierung.

Das ist tausend Mal gesagt worden. Die Politik traut sich aber offensichtlich nicht zuzugeben, mit ihrem liebsten Kind und Aushängeschild „Energiewende“ als Parallelinstrument zum Zertifikatesystem einen Fehlgriff gemacht zu haben. Stattdessen wird argumentiert, wenn man nur die Zahl der Zertifikate reduzierte, dann würde das Ganze schon wieder funktionieren. Dann würde der Preis für die Zertifikate steigen und es würde sich lohnen, in CO2-freie Techniken zu investieren. Dann wäre auch die Energiewende erfolgreich. Aber der Mechanismus lässt sich nicht aushebeln. Klimawirksam wäre auch dann nur die Gesamtzahl der Zertifikate. Jede durch die Energiewende irgendwie zusätzlich vermiedene t CO2 setzte weiterhin entsprechende Zertifikate frei, die kämen wieder auf den Markt, und so weiter, wie gehabt. Der Preis für das Zertifikatesystem ist unvermeidbar, dass Parallelmaßnahmen hierzu zwangsweise Klima-unwirksam sind! Ein Verteuern der Zertifikate ändert an diesem Automatismus nichts.

Einordnung: Bisher habe ich in diesem Beitrag offene Fragen aufgezeigt. Also Punkte, bei denen unser Wissen noch unzureichend ist und für eine endgültige Beurteilung und Entscheidung noch weitere Forschungen und Überlegungen notwendig sind. Bei der genauen Lage des Klimaoptimums ist das so, bei der Gegenrechnung des Nutzens von CO2 und des Schadens von Klimaschutzmaßnahmen ist das so, und bei der Zuverlässigkeit der Klima-Rechenmodelle ist das auch so. Bei der Energiewende ist es anders: Bei näherem Hinsehen ist deren Klima-Unwirksamkeit keine offene Frage, sondern sie ergibt sich logisch zwingend aus dem parallel geltenden EU-Zertifikatesystem! Egal, ob die Energiewende sachlich und finanziell durchführbar ist oder nicht (siehe gleich), Erfolg wird sie auf keinen Fall haben, weil sie bei geltendem Zertifikatesystem keinen haben kann.

Unstete Erzeugung

Kern der Energiewende ist der beschleunigte Ausbau von Wind- und Solarkraftwerken. Deren Erzeugung folgt jedoch nicht dem Bedarf, sondern dem Wetter. Zum Vermeiden von Netzzusammenbrüchen müssen Erzeugung und Verbrauch aber stets ausgeglichen sein. Das geht bei wetterabhängiger Erzeugung nur, wenn ausreichend große Speicher vorhanden sind, um bei Übererzeugung Strom einzuspeichern und bei Untererzeugung Strom aus dem Speicher abrufen zu können. Speicher werden für den Kurzzeitausgleich benötigt, für den jahreszeitlichen Ausgleich und zum Abdecken ggf. längerer Zeiten mit wenig Wind und wenig Sonne („Dunkelflauten“).

Wenn die Stromversorgung Deutschlands weitgehend aus Wind und Sonne bewerkstelligt werden soll, beträgt der hierfür erforderliche Speicherbedarf insgesamt etwa das Fünfhundertfache(!) der derzeit in Deutschland in allen Pumpspeicherkraftwerken zusammen vorhandenen Speicherkapazität. Egal mit welcher Technik das geschehen soll, solche Speicher sind auf absehbare Zeit weder herstellbar noch bezahlbar.

Weil das Speicherproblem so wichtig ist, noch ein paar ergänzende Anmerkungen: Pumpspeicherkraftwerke sind die einzige heute großmaßstäblich verfügbare Speichertechnik. Ein entsprechender Ausbau scheitert in Deutschland aber an der nicht vorhandenen Geographie, selbst wenn der Widerstand der Bevölkerung überwunden und die Kosten aufgebracht werden könnten. Bei dem oft als Lösung angesehenen Power-To-Gas-Verfahren, bei dem zunächst per Elektrolyse Wasserstoff erzeugt und dieser dann in das eigentliche Speichermedium Methan umgewandelt wird, beträgt der Wirkungsgrad nur ca. 25 %, drei Viertel der Energie werden vernichtet! Außerdem ist es nur schwer vorstellbar, dass die Speicher real jemals mit dem auf diesem Weg gewonnenen Methan aufgefüllt werden, weil Methan aus Erdgas auf absehbare Zeit viel billiger ist. Ein Funktionieren des Kreislaufes Strom/Methan/Strom ist nicht absehbar.

Ähnlich ist das auch bei allen anderen Speichertechniken. Eine Lösbarkeit des Problems in überschaubarer Zeit ist Wunschdenken, das einer harten Überprüfung nicht stand hält. Aus heutiger Sicht wird die Energiewende infolge des Speicherproblems auf jeden Fall scheitern! Das gilt unabhängig davon, wie viel sie dem Klima theoretisch helfen könnte oder nicht.

Dass Deutschland mit seinen zurzeit ca. 35 % regenerativer Stromerzeugung langsam an eine Grenze stößt, erkennt man an der starken Zunahme negativer Strompreise: Bei „guten Wetterbedingungen“ wird so viel Strom erzeugt, dass niemand ihn haben will, auch geschenkt nicht. Um ihn trotzdem los zu werden (Gleichgewicht zum Verbrauch!), kann man ihn nur gegen Geld im Ausland entsorgen (dann werden dort andere Kraftwerke zurück gefahren). Und bei „schlechten Wetterbedingungen“ müssen weiterhin Kohlekraftwerke mit ihrem relativ hohen CO2-Ausstoß einspringen! Im ausgeprägt windarmen Sommer 2018 war das besonders häufig der Fall. Ohne Speicher kann der Beitrag von Wind und Sonne daher nur mehr sehr begrenzt gesteigert werden und die CO2-Reduktion wird relativ bescheiden bleiben. Da außerdem Wetterlagen häufig in großen Teilen Europas gleich sind, kann das Problem auch nicht durch länderübergreifenden Ausgleich beseitigt werden. Ohne ausreichende Speicher ist eine sichere Stromversorgung aus wetterabhängiger Erzeugung prinzipiell nicht möglich! Es wäre gut, wenn wir das rechtzeitig zur Kenntnis nähmen und nicht erst aus einem großen Blackout schmerzhaft lernten.

Kosten

Für die Energiewende sind in Deutschland bisher Kosten in Höhe von rund 500 Mrd. € aufgelaufen (schon ausgegeben oder fest zugesagt). Bei 80 Millionen Einwohnern sind das über 5000 € pro Kopf, vom Kind bis zum Greis! Mit jedem Jahr Fortsetzung wächst der Betrag um mindestens 25 Mrd. € (über 250 € pro Kopf, Jahr für Jahr!). In Frankreich hat sich der Protest der Gelben Vesten an den Kosten der Klimabekämpfung (Steuern auf Benzin und Diesel) entzündet. Es ist zu erwarten, dass auch in Deutschland die Menschen nicht mehr lange bereit sein werden, so viel Geld für die Energiewende auszugeben (viele können es heute schon nicht mehr, die Energiearmut ist in Deutschland stark im Steigen begriffen). Wenn (extrem unwahrscheinlich) die Energiewende aus keinem anderen Grund abgebrochen werden sollte, dann wird sie aller Voraussicht nach aus Kostengründen unvollendet eingestellt werden.

Bewertung

Auf absehbare Zeit lässt sich der angestrebte und von vielen als notwendig erachtete Klimaschutz mit den beschlossenen Maßnahmen schlichtweg nicht erreichen. Wenn man ihn doch haben will (oder gar braucht), muss man grundsätzlich andere Maßnahmen anwenden! Mit intensiver Unterstützung durch Kernenergie z. B. könnte es gehen, aber das ist ein anderes Thema, das insbesondere in Deutschland einem Denkverbot unterliegt.

Das Gleiche gilt auch für die Frage, ob man Klimaschutz wirklich durch Reduzieren der (vermuteten) Ursachen des Klimawandels betreiben soll oder besser durch Anpassung an den Klimawandel (Stichwort: Dämme bauen). Das hätte den Vorteil, auch dann zu wirken, wenn man sich hinsichtlich der Ursachen des Klimawandels geirrt hat. Aber auch das ist ein anderes Thema. Nur sollten diese anderen Themen auch überlegt werden, bevor man schwerwiegende Entscheidungen trifft.

Schlussbemerkungen

Unbegreiflich

Eigentlich ist es unbegreiflich: Wir basieren unsere Entscheidungen auf unsicherem Wissen und ignorieren gesichertes Wissen. Einige besonders auffallende Punkte:

- Wir wissen nicht, welches Klima optimal ist, wir wissen nicht, wie groß die Klima-Sensitivität des CO2 tatsächlich ist, und wir legen einschneidende Gegenmaßnahmen mit erkennbar unsicheren Rechenmodellen fest. Unbegreiflich!

- Wir wissen, dass CO2 das Pflanzenwachstum verbessert und damit den Hunger auf der Welt reduziert, aber wir berücksichtigen das bei unseren Entscheidungen nicht. Unbegreiflich!

- Wir wissen, dass über eine Milliarde Menschen dringend und sofort billige Energie benötigen, um aus Hunger und Elend heraus zu kommen (und um das Bevölkerungswachstum einzudämmen), aber wir gönnen sie ihnen nicht, weil wir gegen Ende des Jahrhunderts Klima-Gefahren befürchten. Unbegreiflich!

- Wir wissen, dass die Energiewende parallel zum Zertifikatesystem nicht erfolgreich sein kann, aber wir setzen sie trotzdem unbeirrt fort. Unbegreiflich!

- Wir wissen, dass Wind und Sonne ohne umfangreiche Speicher nur einen unzureichend kleinen Teil unserer Energieversorgung übernehmen können, aber wir stecken trotzdem sehr viel mehr Geld in den Ausbau von Wind und Sonne als in die Entwicklung geeigneter (und bezahlbarer!) Speicher. Unbegreiflich!

- Wir wissen, dass die eingeleitete Energiewende nicht zuletzt auch an ihren horrenden Kosten unvollendet scheitern wird, aber wir geben weiterhin ungeheure Geldsummen für sie aus. Unbegreiflich!

- Wir messen, dass die Erwärmung sich verlangsamt hat, aber wir nehmen das nicht zur Kenntnis. Unbegreiflich.

Zumindest für mich unbegreiflich ist schließlich auch, wie sich bei all diesem in einem Großteil der Medien und in der veröffentlichten Meinung ein „heiles“ Bild der Klimawissenschaft aufrecht erhalten kann. Alles wäre geklärt, die Schuld des Menschen wäre bewiesen und drastische Verhaltensänderungen wären unumgänglich. Wahrscheinlich ist Wissenschaft nie „settled“, beim Klima ist sie das heutzutage auf keinen Fall. Und wahrscheinlich spürt das die „breite Masse“ besser als die veröffentlichte Meinung.

Gut gemeint

Eine Erklärung für diese einseitige Darstellung in der Öffentlichkeit könnte vielleicht im weit verbreiteten Wunsch liegen, etwas Gutes zu tun. Die Welt vor der Klimakatastrophe zu retten, wäre so etwas. Das können wir jedoch nur tun, wenn die Klimakatastrophe wirklich droht, wenn sie vom Menschen verursacht ist und wenn sie durch eine Änderung seines Verhaltens abgewendet werden kann. Also muss das alles so sein, von der Analyse der Situation bis hin zu den abgeleiteten Handlungsempfehlungen. Aber „gut gemeint“ ist oft das Gegenteil von „gut“. Bei den vielen offenen Fragen zum Klimaschutz ist die Gefahr groß, dass genau das hier zutrifft. Dann hätten wir viele Ressourcen aufgewendet, die dann an anderer Stelle fehlen, ohne damit etwas Positives zu erreichen.

Die Lösung

Wenn die Wissenschaft sich tatsächlich einig ist und alles geklärt hat, dann sollten ihre Vertreter die in diesem Beitrag aufgeworfenen Fragen umgehend schlüssig und nachvollziehbar beantworten können. Das wäre die einfache Lösung. Ich höre gerne zu und lasse mich auch gerne überzeugen. Was ich einfordere, ist eine sachliche und vorurteilslose Diskussion. Nicht Überzeugungen sind gefragt, sondern solide Argumente! Wenn die die „veröffentlichte Meinung“ bestätigen, dann ist das eben so, dann müssen wir die Konsequenzen tragen, insbesondere CO2-Freisetzungen massiv reduzieren.

Wenn die „einfache Lösung“ aber nicht geht, dann bleiben die Zweifel aufrecht. Dann müssen intensive Forschungsanstrengungen zur Klärung der offenen Fragen prioritär durchgeführt werden. Das wäre die „aufwändige Lösung“. Aber nur so können Fehlschläge vermieden werden. Je schwerwiegender das Problem ist, desto dringender ist es, vorab die richtige Richtung sicherzustellen.

Zeitdruck

Vielfach wird dem entgegen gehalten, dass wir für solche Abklärungen nicht mehr Zeit hätten. Längeres Hinauszögern energischer Klimaschutz-Maßnahmen würde das Problem unlösbar machen und wir wüssten ohnehin schon genug, um gesichert in die richtige Richtung zu gehen. Dem kann ich aus 3 Gründen nicht zustimmen:

- Erstens gibt uns die Abflachung der Temperaturentwicklung im 21. Jahrhundert sehr wohl Zeit, Fragen zu klären, wir müssen diese Abflachung nur zur Kenntnis nehmen.

- Zweitens ist es mit unserem Wissen an vielen Stellen so weit nicht her, wie die Ausführungen in diesem Beitrag m. E. klar belegen.

- Drittens schließlich kann es wohl kaum einen entscheidenden Einfluss auf die Erfolgschancen haben, ob wir mit entschiedenen Gegenmaßnahmen von den heute in der Atmosphäre vorhandenen 400 ppm CO2 aus beginnen, oder – so wir sie denn tatsächlich brauchen – in z. B. 5 Jahren von dann ca. 410 ppm aus. In dieser Zeit kann aber hinsichtlich Notwendigkeit und richtiger Auswahl der Maßnahmen sehr viel an zusätzlichen Erkenntnissen gewonnen und Fehlentscheidungen können vermieden werden. Es muss nur die Forschung an den richtigen Stellen ergebnisoffen vorangetrieben werden. Das sollten wir tun!